Gli scienziati dell’Università della California a San Francisco e dell’Università della California a Berkeley hanno creato un sistema unico che ha permesso a una donna con grave paralisi dovuta a un ictus al tronco encefalico di comunicare utilizzando un avatar digitale.

Il sistema sintetizza il parlato e le espressioni facciali dai segnali cerebrali e li traduce in testo a una velocità di quasi 80 parole al minuto. I risultati dello studio sono stati pubblicati il 23 agosto 2023 sulla rivista Nature.

Il sistema si basa sulla tecnologia Brain-Computer Interface (BCI) su cui il dottor Edward Chang, presidente di Neurochirurgia presso l’UCSF, lavora da più di un decennio. Spera che nel prossimo futuro questa tecnologia riceva l’approvazione della FDA e diventi disponibile per i pazienti che hanno perso la capacità di parlare a causa di un ictus o per altre cause.

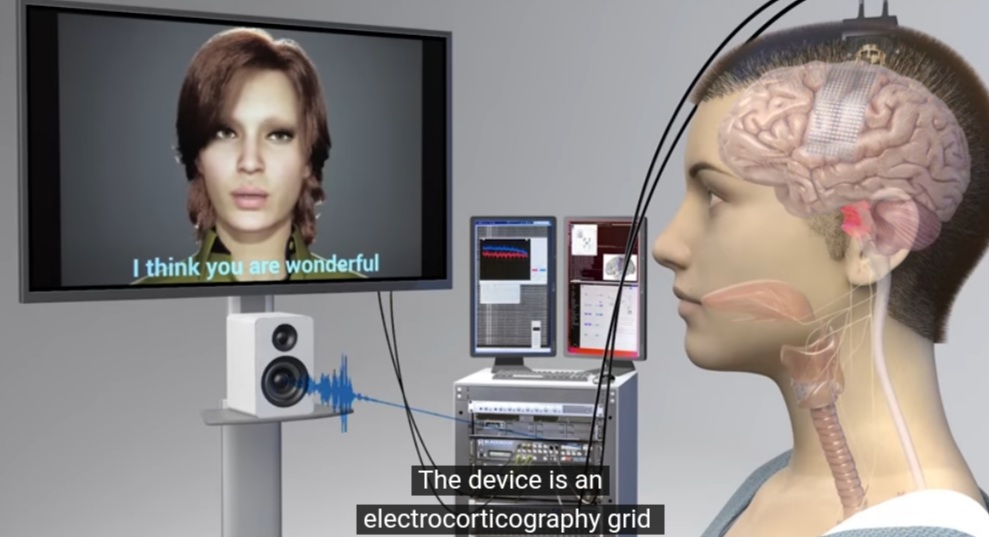

Per far funzionare il sistema, Chang ha impiantato un sottile rettangolo di 253 elettrodi sulla superficie del cervello della donna, sopra le aree responsabili della parola. Gli elettrodi intercettano i segnali cerebrali che controllano i muscoli della lingua, della mascella, della laringe e del viso. I segnali venivano poi trasmessi tramite cavo ai computer, che li elaboravano utilizzando l’intelligenza artificiale (AI).

Per diverse settimane, la partecipante ha lavorato con un team per addestrare gli algoritmi dell’intelligenza artificiale a riconoscere i suoi segnali cerebrali unici per la parola: ha addestrato il sistema ripetendo frasi diverse da un vocabolario conversazionale di 1.024 parole.

Invece di insegnare all’intelligenza artificiale a riconoscere le parole intere, i ricercatori hanno creato un sistema che decodifica le parole dai fonemi.

Utilizzando questo approccio, il computer ha dovuto imparare solo 39 fonemi per decifrare qualsiasi parola in inglese. Ciò ha migliorato la precisione del sistema e lo ha reso tre volte più veloce.

Per creare la voce della donna è stato utilizzato un algoritmo di sintesi vocale, sintonizzato sul suono della sua voce prima dell’ictus.

L’avatar della donna ha preso vita grazie a un software che imita i movimenti dei muscoli facciali. Basato sull’intelligenza artificiale, si sincronizzava con i segnali cerebrali della donna, creando espressioni delle labbra, della lingua e del viso.

Gli scienziati sperano che questo risultato tecnologico possa ripristinare la capacità delle persone di comunicare e interagire con il mondo, anche dopo gravi ictus.

Tuttavia, il prossimo passo importante è creare una versione wireless dell’interfaccia in modo che i pazienti non siano fisicamente collegati al dispositivo.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…