Il 27 marzo, il team di OpenAI ha risolto una vulnerabilità critica in ChatGPT, che consente, all’insaputa della vittima, di assumere il controllo del suo account, visualizzare la cronologia della chat e accedere alle informazioni di pagamento. L’errore è stato segnalato alla società da Nagli bughunter il quale ha fornito una dimostrazione video.

The team at @OpenAI just fixed a critical account takeover vulnerability I reported few hours ago affecting #ChatGPT.

— Nagli (@naglinagli) March 24, 2023

It was possible to takeover someone's account, view their chat history, and access their billing information without them ever realizing it.

Breakdown below 👇 pic.twitter.com/W4kXMNy6qI

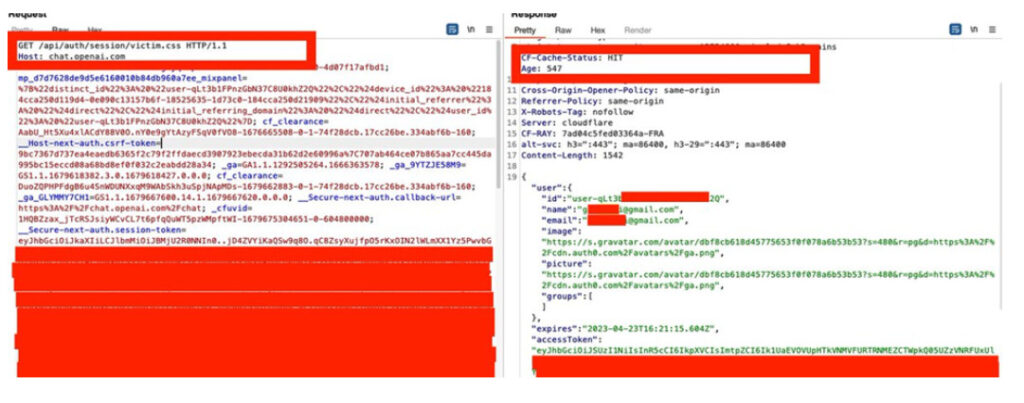

Il ricercatore è riuscito a eseguire un attacco Web Cache Deception. Durante l’esame delle richieste che elaborano il flusso di autenticazione ChatGPT, lo specialista ha notato una richiesta GET che può rivelare informazioni sull’utente: “https://chat.openai.com/api/auth/session”

Ogni volta che accedi a un’istanza di ChatGPT, l’applicazione recupera le informazioni sull’account (e-mail, nome, immagine e token di accesso) dal server.

L’esperto ha simulato una situazione in cui una vittima riceve da un utente malintenzionato un collegamento a una risorsa inesistente con un’estensione di file aggiunta all’endpoint: “chat.openai.com/api/auth/session/test.css”

OpenAI restituisce i dati sensibili in JSON dopo aver aggiunto l’estensione file “css”. Ciò potrebbe essere dovuto a un errore delle regex o semplicemente perché gli sviluppatori non hanno tenuto conto di questo vettore di attacco.

Successivamente, lo specialista ha modificato l’intestazione della risposta “CF-Cache-Status” nel valore “HIT”. Ciò significa che i dati sono stati memorizzati nella cache e verranno restituiti alla richiesta successiva allo stesso indirizzo. Di conseguenza, l’attaccante ottiene i dati necessari per intercettare il token della vittima.

Modello di attacco:

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…