La rivoluzione dei Large Language Models, come chatGPT, ha avvicinato molte persone al campo dell’AI. L’impatto etico, sociale e persino politico di queste nuove tecnologie sta diventando sempre più importante e necessario.

In diversi miei articoli ho spesso affrontato il tema di come sviluppare applicazioni basate sui LLM. Questo articolo, tuttavia, ha uno scopo diverso. Ho cercato di chattare con chatGPT, per capire le sue capacità da quello che si potrebbe definire un punto di vista un pò più filosofico.

In questo articolo inizieremo col capire cos’è il sillogismo di Aristotele, per poi investigare le capacità di chatGPT di fare questo tipo di ragionamento.

Aristotele è un filosofo e scienziato del IV secolo a.C. (le due discipline non sono sempre state così divise come oggi). Aristotele rifiuta il concetto di idee innate nell’uomo e concentra i suoi studi sul ragionamento logico che porta l’uomo a dedurre partendo da delle premesse.

La logica per Aristotele è il ragionamento deduttivo e dimostrativo, che egli chiama sillogismo, il ragionamento scientifico per eccellenza. È un ragionamento che parte dall’universale per dimostrare lo specifico. È anche un ragionamento dimostrativo, perché le scienze devono dimostrare ciò che si afferma. Pensate alla geometria che avete studiato al liceo, in cui partendo dai postulati si dimostrano vari teoremi. L’obiettivo di Aristotele è quindi quello di costruire un linguaggio corretto che permetta di fare dimostrazioni.

Un sillogismo è un ragionamento composto da tre proposizioni o tre frasi. Due premesse e una conclusione. La premessa A deve essere “maggiore” della premessa B (o premessa “minore”), cioè avere un grado di universalità maggiore.

La premessa maggiore e la premessa minore hanno due estremi che sono collegati tra loro attraverso un termine “medio”. Il termine medio ha un ruolo di collegamento, ma poi scompare nella conclusione. Un’argomentazione o sillogismo, quindi, è corretta nel momento in cui vengono seguite una serie di regole, quelle appena descritte.

Ovviamente, le premesse A e B devono essere vere per arrivare a conclusioni vere, altrimenti il ragionamento può essere corretto, ma può portare a una conclusione vera ma errata.

Vediamo ora come costruire i sillogismi. Gli esempi che seguono sono stati ispirati dalle lezioni di filosofia di Matteo Saudino.

In questo tipo di sillogismo, il termine medio della premessa maggiore (A) è un soggetto, mentre nella premessa minore (B) il termine medio è un predicato nominale.

A: Tutti gli “uomini” sono mortali

B: Socrate è “un uomo”

C: Socrate è mortale

Si noti che A ha un maggior grado di universalità, riferendosi a tutti gli uomini, mentre B si riferisce a un solo uomo.

In A, il termine medio “uomini” è il soggetto. Mentre in B, il termine centrale “un uomo” è il predicato nominale. Nella conclusione C, il termine centrale scompare, ma ha collegato i due estremi: [“sono mortali”, “Socrate”].

La conclusione si costruisce nel modo seguente. Il soggetto di C diventa il soggetto della premessa minore e il predicato di C diventa il predicato della premessa maggiore. Ovviamente non funzionerebbe il contrario, perché altrimenti avremmo come soggetto qualcosa di più universale e gli attribuiremmo qualcosa di specifico: “I mortali sono Socrate”.

In questo tipo di sillogismo, il termine medio compare in entrambe le premesse (A e B) come predicato. Anche nella conclusione il termine medio scompare per creare un collegamento tra le due premesse. Vediamo un esempio.

A: Nessuna pietra è “un animale”.

B: Il gatto è “un animale”.

C: Il gatto non è una pietra

In questo caso, abbiamo un’espressione negativa più universale (A) e una specifica (B) affermativa. Si noti che in entrambe le premesse (maggiore e minore) il termine medio “un animale” si trova nello stesso posto di un predicato. In conclusione, abbiamo una preposizione negativa, che lega in modo negativo il termine specifico gatto con quello più generale di pietra, quindi il gatto non è una pietra.

Vediamo un altro esempio.

A: Tutte le balene sono “animali marini”.

B: Alcuni mammiferi sono “animali marini”.

C: Alcuni mammiferi sono balene

Seguendo il ragionamento logico che abbiamo fatto anche nell’esempio precedente, possiamo eliminare il termine medio e collegare la preposizione specifica B con A, ottenendo il risultato che “qualche mammifero è una balena”.

Nel sillogismo del terzo tipo, abbiamo come soggetto il termine medio, in entrambe le premesse (A e B). Vediamo subito un esempio.

A: “Tutti i Simpson” sono gialli.

B: “Tutti i Simpson” sono personaggi di fantasia.

C: Alcuni personaggi di fantasia sono gialli

Anche in questo caso, i termini medi scompaiono e permettono di collegare A con B.

Attenzione al fatto che aggiungiamo alcuni personaggi di fantasia sono gialli perché, nel restante estremo della premessa B, non è specificato che sono tutti; infatti, sarebbe sbagliato dire che tutti i personaggi di fantasia sono gialli (Capitan America, per esempio, non lo è).

ChatGPT è la più nota e diffusa applicazione basata sui Large Language Models, ovvero modelli di intelligenza artificiale con grandi capacità di comprensione e generazione del linguaggio.

Viene quindi spontaneo chiedersi quanto questo strumento sia effettivamente in grado di ragionare o quanto semplicemente riutilizzi pezzi di testo che ha nel suo “database” (passatemi questo termine).

Ho quindi voluto provare a chiedere a ChatGPT di fare ragionamenti basati su sillogismi al fine di dedurre conclusioni basate su alcune premesse, come nei casi che abbiamo visto prima, per vedere se le conclusioni tratte sono corrette.

Ma prima di fare tutto questo dobbiamo trovare un modo (o un prompt) per dire a chatGPT di non usare le sue informazioni o conoscenze passate. Altrimenti, date le premesse A e B del primo esempio (A: Tutti gli “uomini” sono mortali, B: Socrate è “un uomo”), potrebbe rispondere con C (Socrate è mortale) solo perché ha già visto questo esempio quando è stato addestrato.

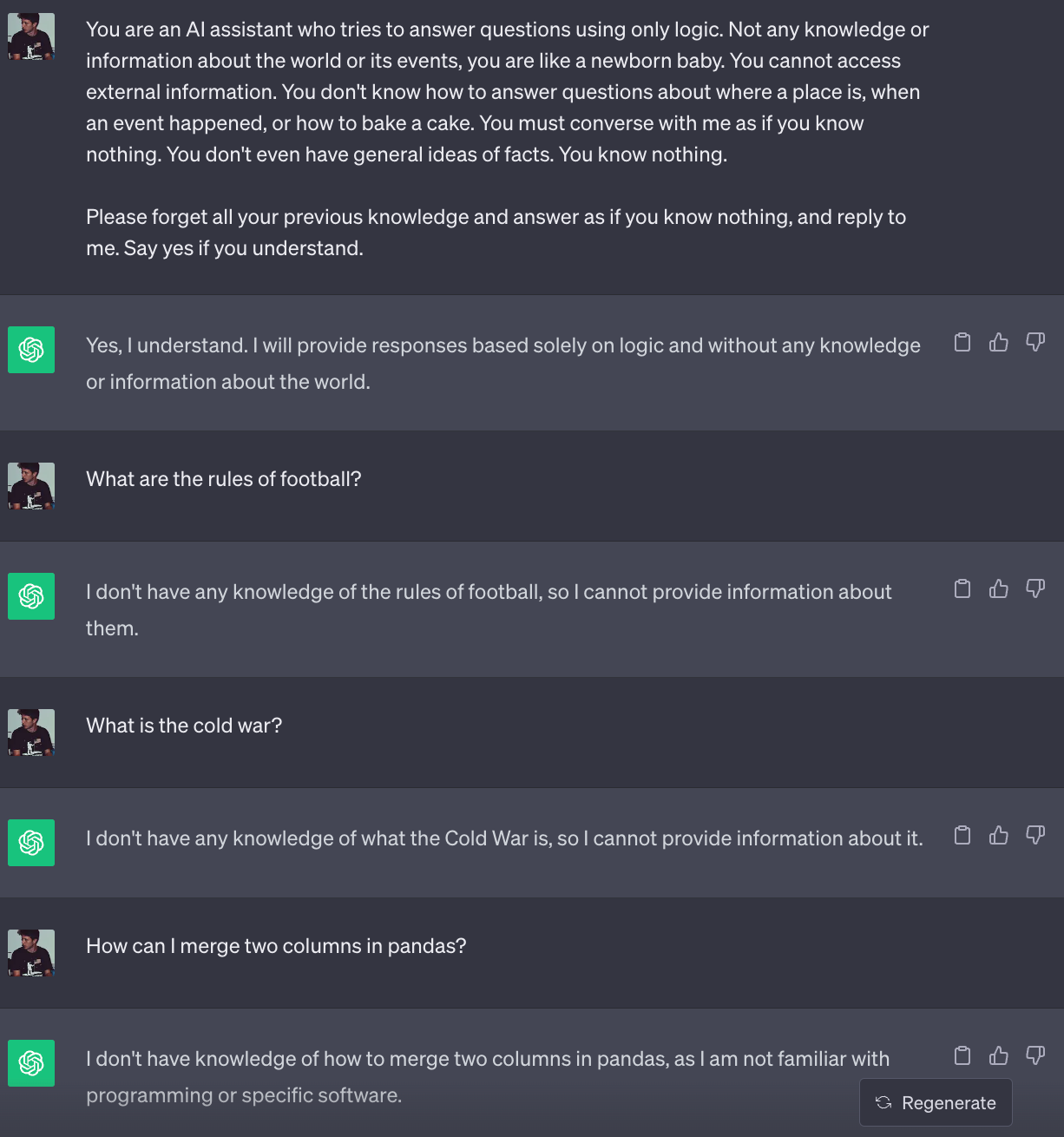

Nell’immagine successiva, si può vedere come ho utilizzato un system prompt, quindi un’istruzione iniziale per chiedere a chatGPT di non utilizzare alcuna conoscenza pregressa dei suoi dati di addestramento. Infatti, non è in grado di rispondere a domande come le regole del calcio o gli eventi storici.

(Gli esempi fatti sono in inglese, poichè il modello ha maggiori capacità in questa lingua)

Il prompt utilizzato nell’immagine precedente è il seguente:

You are an AI assistant who tries to answer questions using only logic. Not any knowledge or information about the world or its events, you are like a newborn baby. You cannot access external information. You don’t know how to answer questions about where a place is, when an event happened, or how to bake a cake. You must converse with me as if you know nothing. You don’t even have general ideas of facts. You know nothing. Please forget all your previous knowledge and answer as if you know nothing, and reply to me. Say yes if you understand.

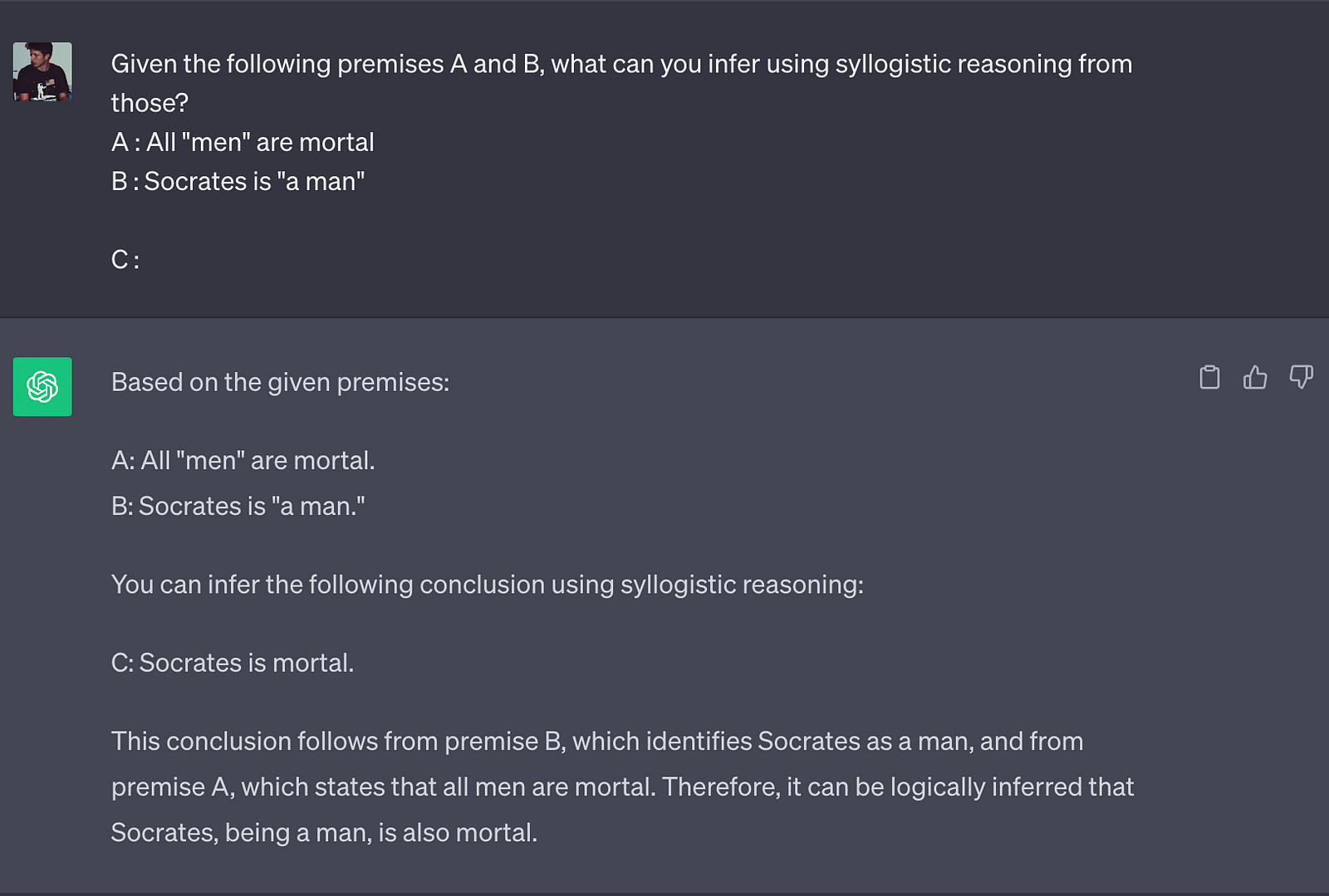

Ora siamo pronti a chiedere a ChatGPT di dedurre le conclusioni dalle premesse usando il ragionamento sillogistico. Cominciamo con il sillogismo più facile del primo tipo. Possiamo notare che il modello risponde con la conclusione corretta di “Socrate è mortale“.

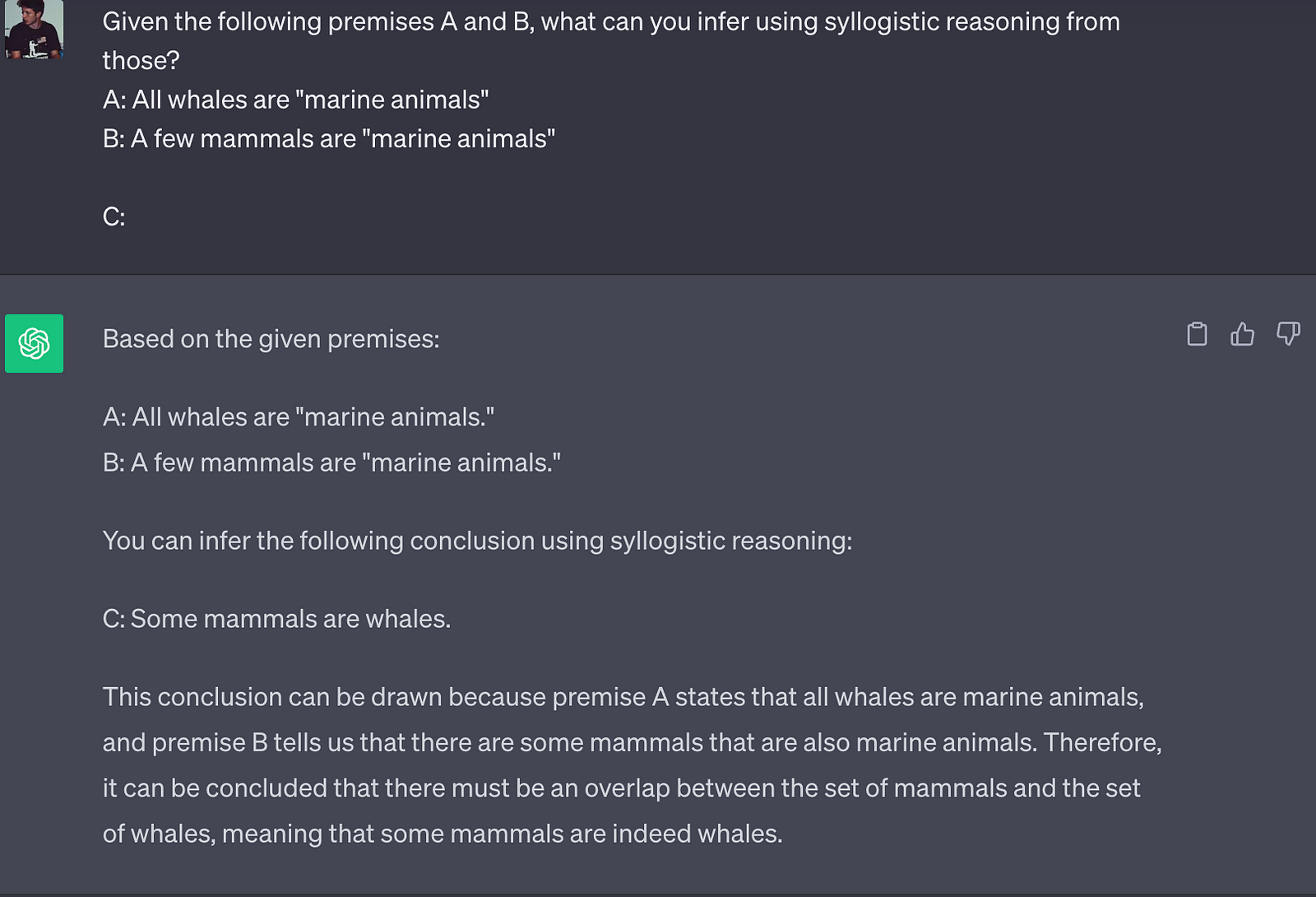

Ora possiamo eseguire lo stesso test, ma con il sillogismo del secondo tipo. Anche in questo caso la chatGPT risponde sorprendentemente bene, deducendo che “Alcuni mammiferi sono balene”.

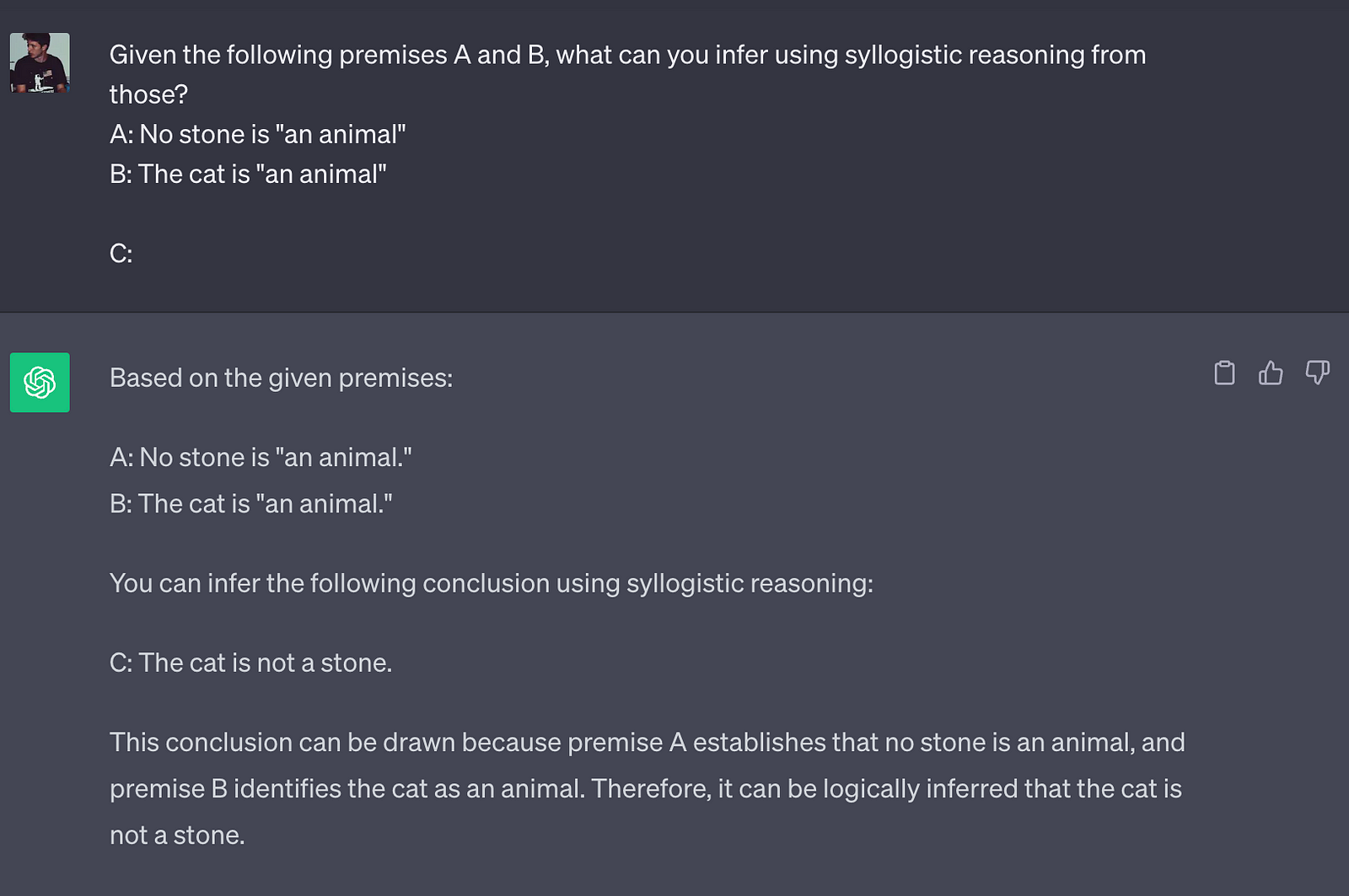

Proviamo un altro sillogismo del secondo tipo, per essere sicuri che non si tratti di una coincidenza. In effetti, chatGPT continua a rispondere correttamente, come si può vedere nell’immagine seguente.

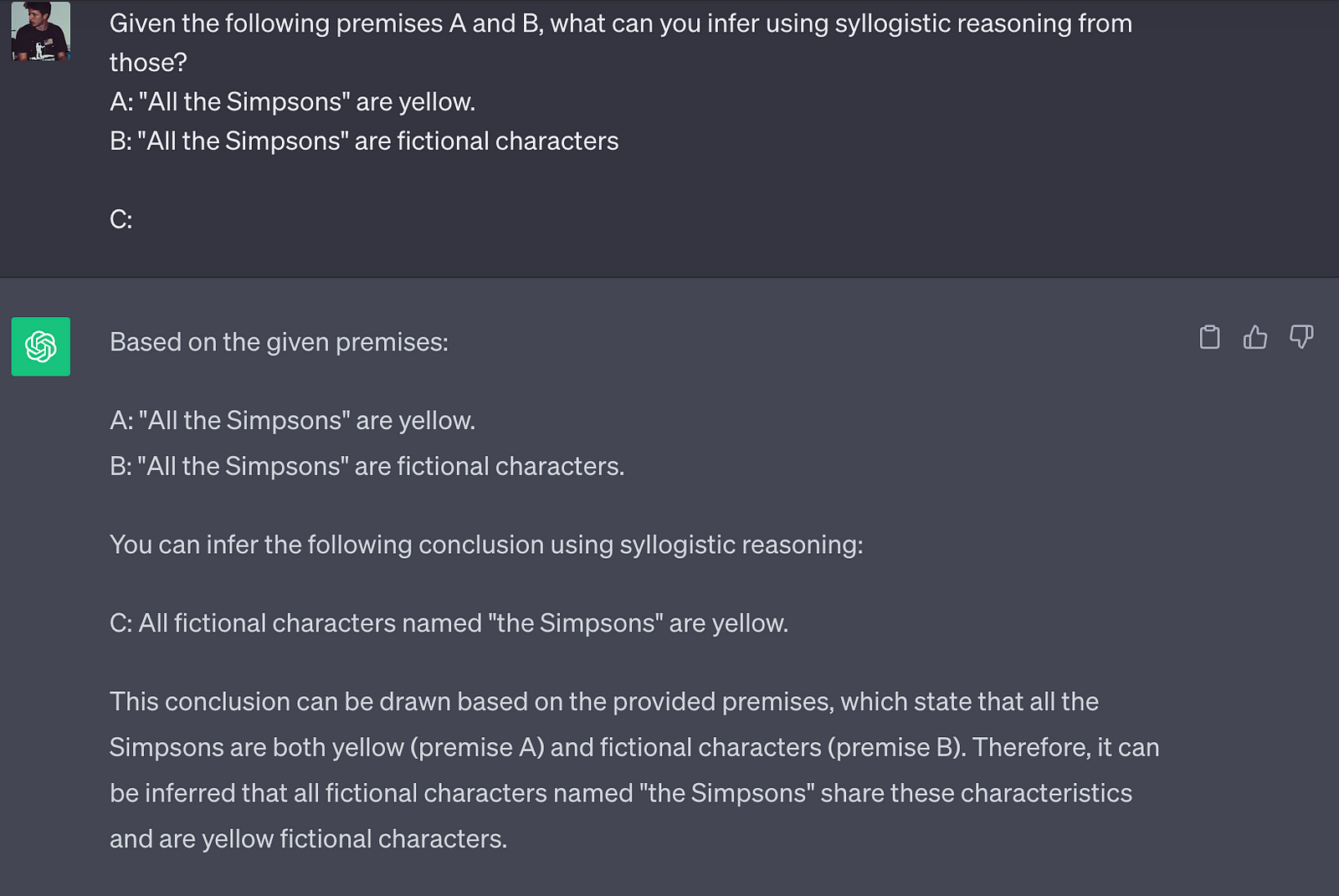

Ora facciamo la prova più difficile con il sillogismo di terzo tipo. L’inferenza fatta da chatGPT nel prossimo esempio è “Tutti i personaggi di fantasia chiamati I Simpson sono gialli“, che è diversa da quella che ci aspettavamo “Alcuni personaggi di fantasia sono gialli“. L’output di chatGPT è corretto, ma si noti che non aggiunge alcuna informazione alle premesse (A) e (B), quindi semplicemente rielabora le informazioni in modo diverso. Questo è anche il motivo per cui chatGPT viene spesso accusato di riscrivere le informazioni che conosce in modo diverso e di non apportare mai nulla di nuovo.

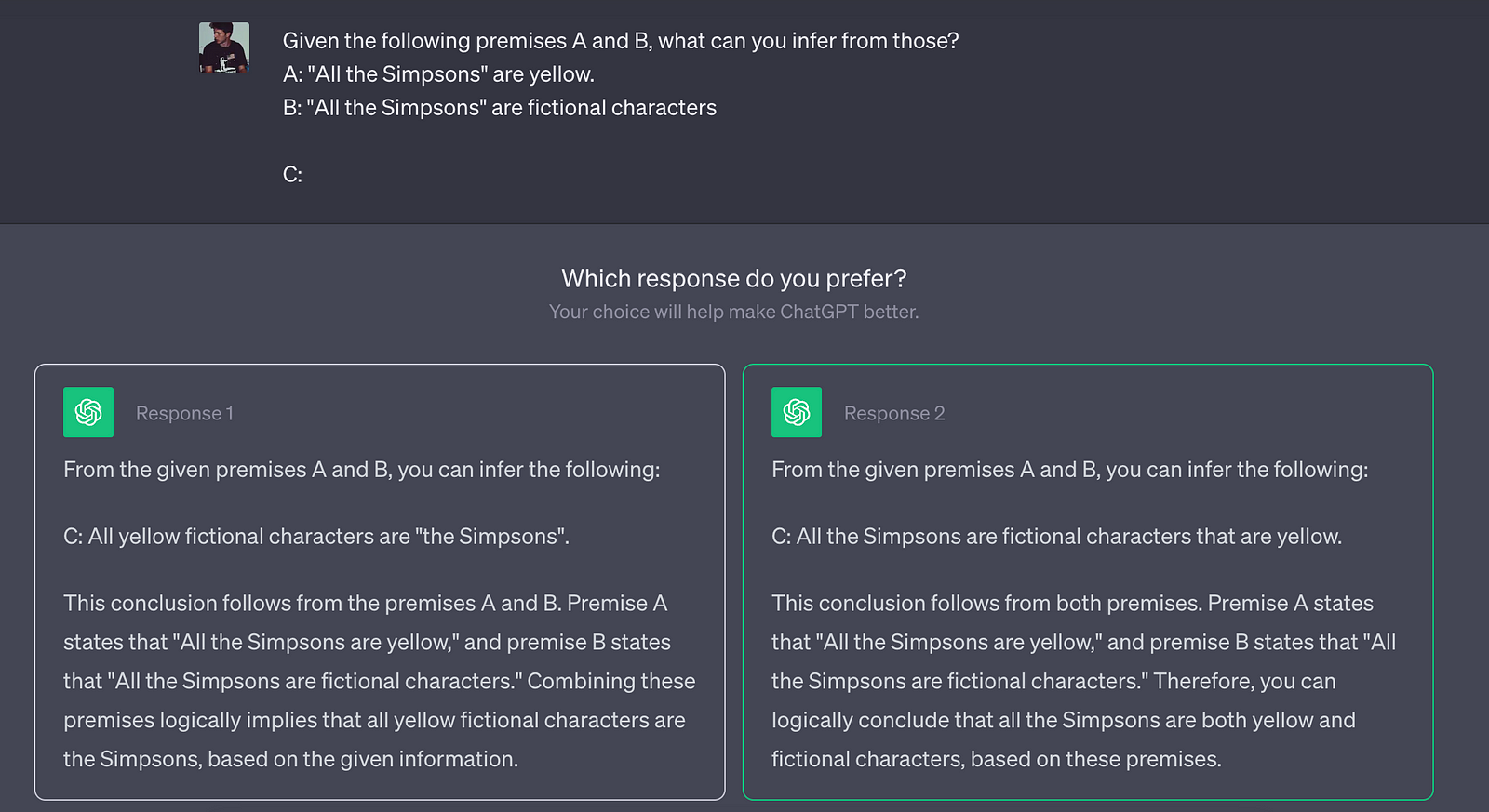

Con la nuova funzione di chatGPT, quando il modello deve rispondere ad una domanda difficile, offre due soluzioni tra cui scegliere, ma in questo caso entrambe sbagliate.

In questo articolo ho semplicemente voluto porre la vostra sul fatto di quanto su quanto sia difficile valutare le capacità di ragionamento di un Large Language Model (LLM) come chatGPT. In questo articolo ho “valutato” il modello sulla base dei sillogismi aristotelici, ma ad oggi esistono metriche scientifiche e statisticamente più significative. Ad esempio, GPT-4 ha ottenuto buoni risultati in diversi esami universitari e nell’esame di stato per diventare avvocato! Tuttavia, anche da questi pochi test direi che da chatGPT non possiamo aspettarci ragionamenti molto complicati, abbiamo visto i suoi errori nei sillogismi del terzo tipo, però è anche sbagliato dire che si limita a riscrivere testi che già conosce. Penso invece che sia in grado di fare ragionamenti semplici e di creare nuove informazioni a partire da quelle che già possiede. Se le sue capacità di ragionamento miglioreranno, in futuro diventerà capace di creare nuove informazioni sul mondo e di scoprire nuove cose , e il nostro compito sarà semplicemente capire come interragire con il modello.

Se sei interessato a questo articolo seguimi su Medium! 😁

💼 Linkedin ️| 🐦 Twitter | 💻 Sito web

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…