Gli scienziati di Google e dell’Università di Osaka in Giappone sono stati in grado di ricreare la musica basata sull’attività del cervello umano. Il modello è stato chiamato Brain2Music.

L’esperimento è iniziato con un gruppo di soggetti che ascoltavano campioni di musica di vari generi (rock, classica, metal, hip-hop, pop, jazz e altri).

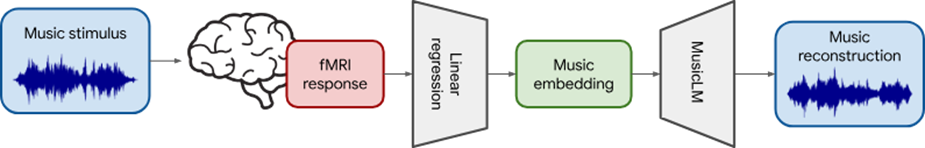

Mentre ascoltavano, gli scienziati hanno utilizzato la risonanza magnetica funzionale (fMRI) per registrare l’attività cerebrale degli ascoltatori. I dati risultanti sono stati quindi utilizzati per addestrare la rete neurale a rilevare attività associate a varie caratteristiche della musica, come genere, umore e strumentazione.

Schema di studio

Un passaggio chiave nella ricerca ha comportato l’utilizzo del modello MusicLM di Google. Questo modello genera musica sulla base di descrizioni testuali.

Dopo aver collegato il database MusicLM con i dati fMRI, gli scienziati sono stati in grado di sviluppare un modello di intelligenza artificiale che ha ricreato la musica ascoltata dai soggetti. Invece delle istruzioni testuali per MusicLM, l’attività cerebrale ha fornito il contesto per l’output musicale.

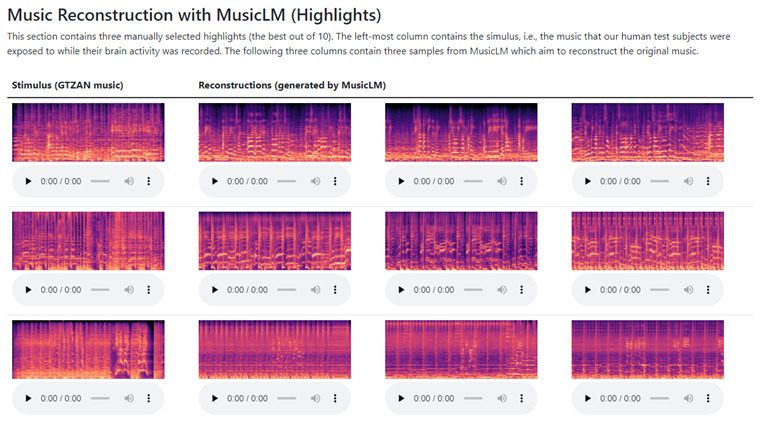

Gli scienziati forniscono esempi delle migliori generazioni di Brain2Music

La musica ricreata è semanticamente simile al motivo musicale originale, poiché l’IA crea musica che riproduce i motivi ascoltati dai soggetti del test in termini di proprietà semantiche, come genere, strumentazione e umore.

Ad esempio, nella “copia” di una canzone, il suono degli strumenti e il ritmo corrispondevano bene all’originale, ma le parole erano illeggibili. Secondo gli scienziati, il modello Brain2Music si concentra sulla ricreazione della strumentazione e dello stile, non del testo.

Gli esperti hanno notato che lo studio fornisce per la prima volta un’interpretazione quantitativa da un punto di vista biologico. Nonostante i progressi nei modelli di testo in musica, il funzionamento interno di tali modelli è ancora poco compreso.

Tuttavia, la possibilità di ricreare melodie perfettamente orchestrate basate sull’attività cerebrale potrebbe diventare una realtà nel prossimo futuro. Gli scienziati affermano che il prossimo passo sarà cercare di ricreare la musica o l’armamentario musicale dall’immaginazione umana.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…