L’intelligenza artificiale (IA) generativa anche se non rappresenta ancora un vero rischio nelle operazioni di influenza è oggi oggetto di numerose incognite critiche, soprattutto per quanto riguarda le minacce derivanti dall’utilizzo dei modelli linguistici generativi (LLMs).

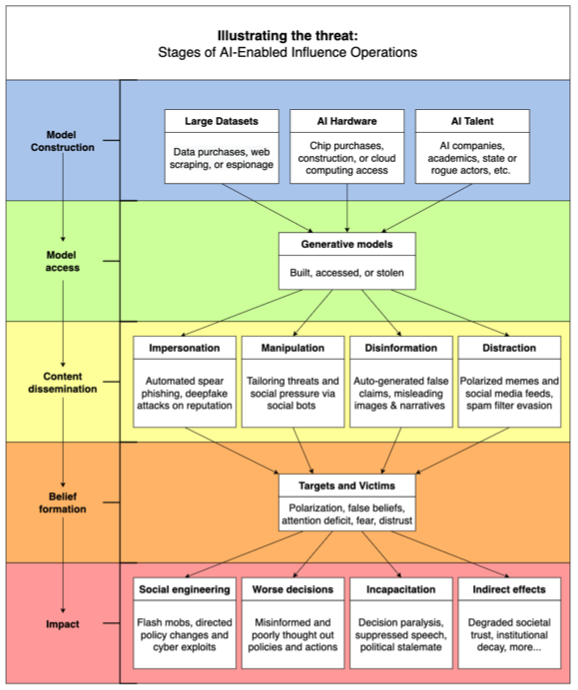

Anche se oggi ne viene fatto un uso limitato e ne sia ancora incerto il ‘valore economico’ relativo ai costi e il loro utilizzo richieda ancora know-how operativo e infrastrutture per essere utilizzata con abilità – il gruppo di intelligence Mandiant, che ne riconosce il potenziale strategico, ritiene che l’IA generativa possa aumentare in modo significativo le capacità degli attori delle operazioni di informazione in due aspetti chiave:

Soprattutto, i modelli di IA generativa, a basso costo, in grado di competere con il linguaggio umano forniscono importanti vantaggi come:

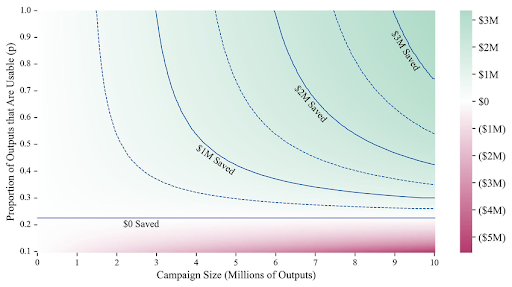

Da non sottovalutare in ultimo – come prima evidenziato – i costi da sostenere in larga scala riguardo alla personalizzazione e il seguente monitoraggio: il recente contributo ‘A Cost Analysis of Generative Language Models and Influence Operations (agosto 2023 – Micah Musser)’ sottolinea come gli LLM debbano “produrre solo output utilizzabili con un’affidabilità relativamente bassa (circa il 25%) per offrire risparmi sui costi ai propagandisti” e che “la potenziale riduzione dei costi di generazione dei contenuti può essere piuttosto elevata (fino al 70% per un modello altamente affidabile)”, tuttavia è “improbabile che gli stati-nazione possano trarre beneficio economico da LLM personalizzati specificatamente per l’uso in operazioni di influenza” anche nel caso di miglioramento del monitoraggio.

Con forti vantaggi operativi nell’influenzare i processi decisionali di ognuno di noi e con l’obiettivo di scardinare la leadership nemica – limitando al massimo l’uso della forza fisica – le campagne di influenza sorrette dall’IA hanno la potenzialità di realizzare campagne personalizzate in base al target, fornendo “metodi di guerra alternativi a quelli tradizionali” [Difesa.it – Le information operations: uno strumento per influenzare i processi decisionali], supportando così anche la pianificazione degli obiettivi strategici e scardinando la leadership nemica.

Le operazioni di influenza, anche nel caso in cui non riescano a cambiare le nostre opinioni, ci portano spesso a chiederci se il contenuto osservato, anche da fonti credibili, sia effettivamente reale, minando potenzialmente la fiducia nelle istituzioni democratiche più in generale. Pensiamo solo ai deep fake – Microsoft ha segnato un aumento del 900% anno su anno nella loro proliferazione per minacciare i processi democratici dei paesi – o alle campagne di intrusione, disinformazione e propaganda, laddove Madiant afferma che l’intelligenza artificiale generativa è pronta ad un’accelerazione. Nel rapporto ‘Threat Actors are Interested in Generative AI, but Use Remains Limited’, rilasciato la scorsa settimana, viene sottolineato che mentre i modelli generativi potrebbero presentare ancora carenze nella produzione di malware, potrebbero invece consentire una produzione di contenuti superiore – per qualità, efficienza e quantità – su larga scala da parte degli attori nations-state che prendono di mira entità geopolitiche.

Immagini, video e testi generati dall’IA con contenuti visivi e uditivi sempre più capillari e persuasivi vengono adattati a narrazioni politiche specifiche e accompagnano conflitti fisici, elezioni, processi decisionali. E’ quanto meno necessario chiedersi – per di più nell’attuale contesto – quali effetti avranno i modelli linguistici generativi sulle operazioni di influenza in futuro e soprattutto quali attori avranno accesso a questi modelli, Infine, in che modo ne verrà accelerato il loro utilizzo nelle operazioni cibernetiche?

Pronti ad investire l’Occidente secondo Fomiche sono i contenuti che originano da Pechino e per i quali il dominio cyber rappresenta un terreno ideale di crescita dove la partita non è “solo una questione tecnica, ma anche di idee e di forza discorsiva”. Basterebbe osservare quotidianamente il profilo Twitter del Ministero degli Esteri cinese per comprendere quanto la forza discorsiva sia fondamentale.

Mentre l’Occidente si è preparato in un certo qual modo alle operazioni di informazioni a carattere offensivo – in particolar modo russe e cinesi – e la Nato vi presti particolare attenzione monitorando contenuti e sviluppandone altri per contrastare l’effetto eco [Vd. Le Formiche], la disponibilità e le capacità degli strumenti pubblicamente disponibili pongono un nuovo problema alla rapida e veloce adozione dell’IA generativa.

Nel 2023 Madiant segnala le immagini utilizzate da DRAGONBRIDGE – rete di influenza spam legata alla Cina con un forte presenza su più piattaforme – per supportare false narrazioni su leader USA (tra gli strumenti Midjourney). Inoltre, le immagini che ritraevano una presunta esplosione vicino al Pentagono condivise da un falso account Twitter (@BloombergFeed) hanno impattato sul mercato azionario americano.

Non solo immagini ma video e audio e utilizzo di reti neurali. Se le reti neurali open source e pre-addestrate possono essere sfruttate per generare media digitali per scopi dannosi” e quindi come armi per campagne IO offensive, “gli strumenti audio generati dall’intelligenza artificiale – afferma Madiant – esistono da anni e possiedono funzionalità come modelli di sintesi vocale, clonazione e rappresentazione vocale”. Ad esempio, la manipolazione vocale è stata utilizzata come add-on di ingegneria sociale per il targeting dei soldati israeliani e utilizzata dal gruppo di hacktivisti filo-russi CyberBerkut, ha consentito già in passato la riproduzione di fabbricazioni audio additate a varie organizzazioni.

Così l’Iran, che concentra per una buona percentuale i suoi sforzi verso Israele – seguito da Stati Uniti, Emirati Arabi Uniti e Arabia Saudita – adottando l’IO abilitato al cyber, ha cercato di mettere in imbarazzo figure di spicco dell’opposizione utilizzando falsi personaggi online per amplificare o pubblicizzare attacchi.

Tra il pre-posizionamento e l’amplificazione di false narrazioni all’interno di un pubblico mirato la minaccia a lungo termine non riguarda governi o organizzazioni ma la nostra comprensione di ciò che è vero e ciò che non lo è. L’IA generativa complica la questione, rendendo sempre più difficile questa distinzione soprattutto laddove i governi devono garantirsi la fiducia dell’opinione pubblica che spesso perde tempo a cercare persone cattive piuttosto che alleati umani.

Molte di queste operazioni oggi non vengono rilevate e percepite oppure si nascondono dietro grandi e piccoli finanziamenti verso istituzioni accademiche o organizzazioni senza scopo di lucro.

Nel maggio 2023 Microsoft ha avvertito sull’utilizzo da parte dell’Iran di una nuova serie di tecniche che attacchi informatici tradizionali con operazioni di influenza abilitate dal cyber (IO) per un maggiore effetto geopolitico: l’accelerazione ha avuto inizio dal giugno del 2022 con un corrispondente calo nell’uso di ransomware e attacchi wiper.

“Iranian cyber actors have been at the forefront of cyber-enabled IO, in which they combine offensive cyber operations with multi-pronged influence operations to fuel geopolitical change in alignment with the regime’s objectives. The goals of its cyber-enabled IO have included seeking to bolster Palestinian resistance, fomenting unrest in Bahrain, and countering the ongoing normalization of Arab-Israeli ties, with a particular focus on sowing panic and fear among Israeli citizens”.

Microsoft

Limitando al massimo l’uso della forza fisica, la potente tecnologia dell’IA generativa, a basso costo e in grado di competere con il linguaggio umano, fornisce importanti vantaggi come: l’ampliamento del target, la sua personalizzazione per influenzare le operazioni e ultimo, ma non meno importante, la sua efficacia e la sua affidabilità, evitando l’errore. Tuttavia questa tecnologia richiede ancora know-how operativo e infrastrutture per essere utilizzata con abilità.

Ad oggi però, l’applicazione dei modelli linguistici generativi rimane un’incognita, soprattutto nel caso di smantellamento e mitigazione delle minacce derivanti dall’utilizzo dei modelli linguistici nelle Info-Ops, che richiede soprattutto un approccio cooperativo importante basato sviluppo, controllo, ricerca, ma soprattutto valutazione dell’efficacia e robustezza di tali modelli.

Una seria analisi della Georgetown University’s Center for Security and Emerging Technology OpenAI in collaborazione con la Stanford Internet Observatory fa luce sulla questione elencando le numerose incognite critiche dei modelli generativi e del loro utilizzo, come:

[Fonte: Generative Language Models and Automated Influence Operations: Emerging Threats and Potential Mitigations]

Nell’ultimo caso, per la questione normativa servirebbe una colazione efficace ed effettiva come è stato fatto nella scrittura della lettera aperta contro ChatGbt-4Chan e le pratiche irresponsabili nell’utilizzo di modelli linguistici, per spingere allo sviluppo norme che vietino l’uso di modelli linguistici per operazioni di influenza. Infine non è chiaro nel lungo termine, chi trarrà maggiori benefici dall’utilizzo dell’intelligenza artificiale: se i difensori o gli attaccanti.

La mitigazione – sottolinea lo studio – avviene secondo 4 fasi o punti principali che riguardano prima di tutto progettazione, sviluppo e regolamentazione:

Ultimo a livello strategico lo sviluppo di partnership nella duplice sfida per combattere le operazioni di influenza: cosa non possibile se prima non si comprenderanno le tattiche, le tecniche e le procedure a monte.

Approfondimenti: Il Pentagono avvia un trial per comprendere come usare l’IA generativa nel dipartimento

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…