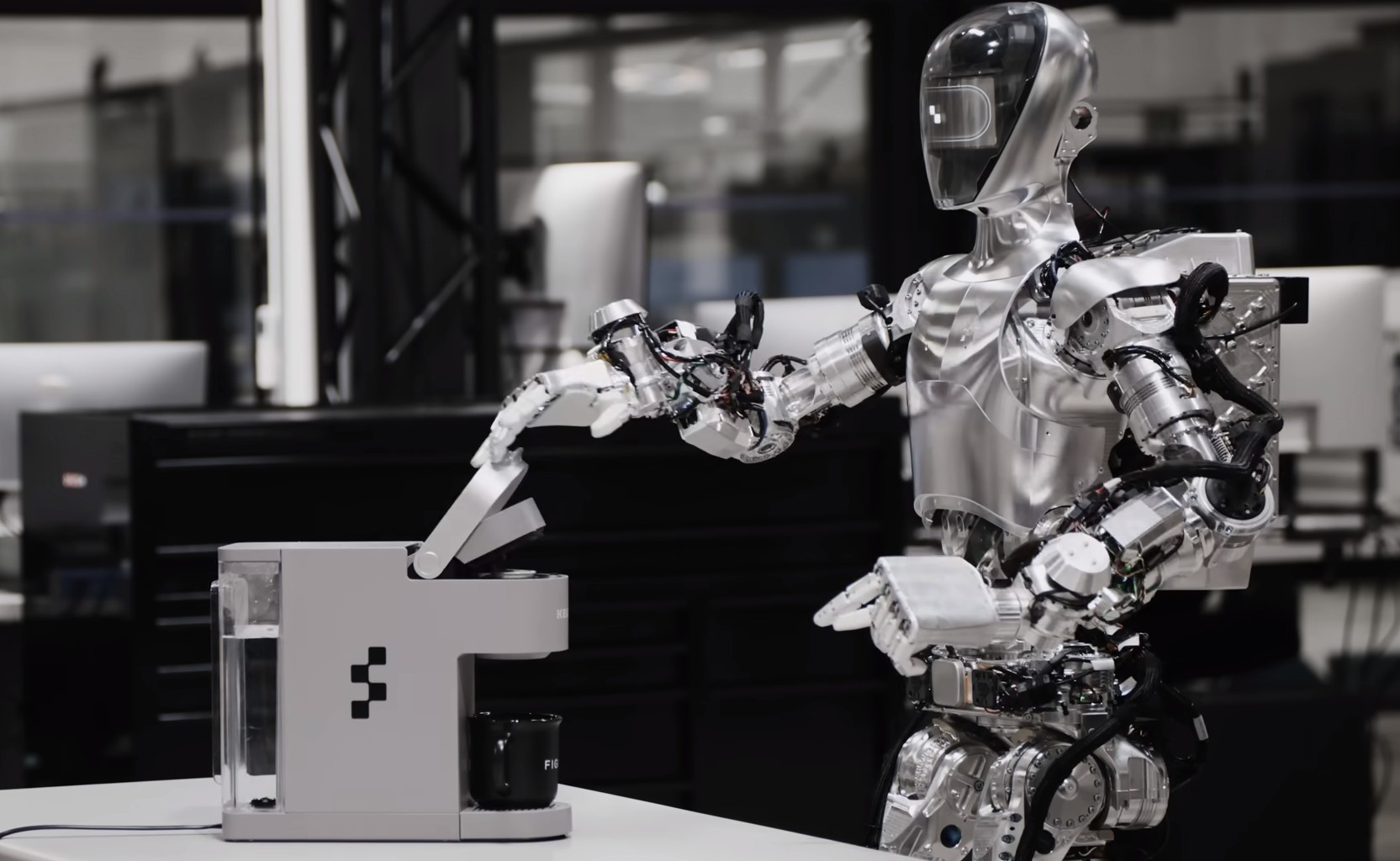

Figure ha presentato i primi frutti della sua collaborazione con OpenAI per migliorare la funzionalità dei robot umanoidi. In un nuovo video, il robot Figure 01 dimostra la capacità di condurre una conversazione in tempo reale.

In breve tempo Figure ha ottenuto un notevole successo. L’imprenditore Brett Adcock è emerso dall’ombra proprio l’anno scorso, riunendo persone chiave di Boston Dynamics, Tesla, Google DeepMind e Archer Aviation per creare “il primo robot umanoide universale commercialmente fattibile al mondo”.

Entro ottobre, Figure 01 era operativa e svolgeva attività autonome di base. Entro la fine dell’anno il robot aveva acquisito la capacità di apprendere utilizzando il principio “guarda e impara” e a metà gennaio era pronto per iniziare a lavorare nello stabilimento BMW.

Il mese scorso, Figure ha pubblicato un video di Figure 01 mentre lavora in un magazzino . Quasi subito dopo, l’azienda ha annunciato lo sviluppo di una seconda generazione della macchina e una collaborazione con OpenAI “per sviluppare una nuova generazione di modelli IA per robot umanoidi”. Ora, Figure ha condiviso un video che mostra i primi risultati di questa collaborazione.

Durante un test dimostrativo, un rappresentante della startup ha incaricato il robot di descrivere gli oggetti che aveva di fronte. Figure 01 ha completato il compito senza difficoltà e poi, quando gli è stato chiesto di “offrire qualcosa di commestibile”, ha passato la mela all’interlocutore. Successivamente, il robot ha posizionato con cura tazze e piatti al loro posto. Allo stesso tempo, ha continuato a parlare con la persona, dimostrando movimenti sicuri e precisi.

Secondo Adcock, le telecamere integrate di Figure 01 inseriscono i dati in un ampio modello di intelligenza artificiale in linguaggio visivo addestrato da OpenAI, e anche le reti neurali proprietarie di Figure “acquisiscono immagini attraverso le telecamere del robot a 10 Hz”. Gli algoritmi OpenAI sono responsabili della capacità di comprendere il parlato e la rete neurale Figure converte il flusso di informazioni ricevute in “azioni robot veloci, precise e abili”.

L’imprenditore ha sottolineato che la dimostrazione è avvenuta senza telecomando e che il video è stato girato a velocità reale. “Il nostro obiettivo è insegnare al modello di intelligenza artificiale a controllare i robot umanoidi a livello di miliardi di unità”, ha affermato, indicando ambiziose prospettive di sviluppo.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…