Una foto su un social media che ritrae una persona può essere utilizzata per molte finalità. Il mondo del cybercrime si sta evolvendo rapidamente e sta inserendo nel suo arsenale l’intelligenza artificiale capace di riprodurre contenuti altamente convincenti.

L’FBI sta avvertendo che le truffe di “estorsione sessuale” si sono intensificati e stanno creando deepfake contenenti contenuti sessualmente espliciti basati su foto delle vittime prese dai social media.

In inglese, per riferirsi a tale attività, si usa il termine sextortion, derivato dalle parole sex (“sex”) ed extortion (“extortion”). Questa tattica comporta l’intimidazione degli utenti: spesso, i truffatori inviano spam in cui cercano di convincere le vittime che hanno immagini o video compromettenti, e poi chiedono un riscatto.

In molti casi, tale estorsione si basa su minacce vuote, poiché gli aggressori fingono solo di avere accesso a contenuti espliciti. Ma ora l’FBI ha avvertito che gli “estorsori sessuali” stanno usando una nuova tattica.

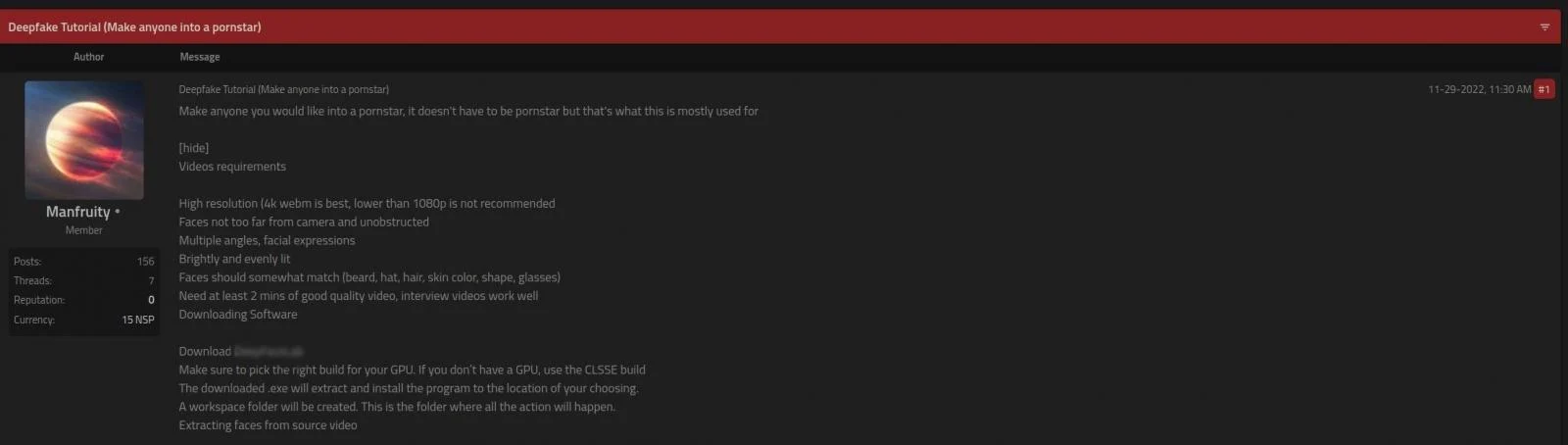

Prendono foto e video pubblici di future vittime dai social network e poi usano queste immagini per creare deepfake, generando contenuti sessuali dall’aspetto falso ma molto convincenti. E il mondo dell’underground sta iniziando a vendere sistemi che creano contenuti espliciti basati su AI come nel caso del post pubblicato recentemente su un noto forum underground.

Sebbene le immagini e i video siano falsi, si prestano bene al ricatto perché sembrano reali e l’invio di tale materiale alla famiglia o ai colleghi della vittima può causare gravi danni alla vittima e alla sua reputazione.

Gli esperti dell’Internet Fraud Complaint Center (IC3) dell’FBI scrivono che, a partire da aprile 2023, hanno documentato un picco di attacchi utilizzando tali immagini e video falsi basati su contenuti dei social media delle vittime o video ripresi durante le chat video.

“Sulla base di recenti rapporti delle vittime, gli aggressori in genere chiedevano: pagamento (come denaro o buoni regalo), minacciando le persone di condividere immagini o video con familiari e amici della vittima”, ha affermato l’FBI.

Le forze dell’ordine scrivono che a volte i truffatori non si rivolgono immediatamente all’estorsione, ma inseriscono deepfake su siti porno, ovviamente, senza la conoscenza e il consenso delle vittime. In alcuni casi, successivamente, gli estorsori utilizzano tali foto e video per aumentare la pressione sulla vittima e chiedono denaro per la rimozione di materiali dai siti. L’FBI sottolinea che questa attività di intrusi, purtroppo, ha già colpito i minori.

Gli esperti osservano che la velocità con cui gli strumenti di intelligenza artificiale per la creazione di contenuti diventano disponibili a un vasto pubblico crea un ambiente ostile per tutti gli utenti di Internet. Ad esempio, ci sono diversi progetti disponibili gratuitamente su GitHub che consentono di creare video dall’aspetto realistico basati solo sull’immagine del volto della vittima, senza ulteriore formazione e set di dati.

Molti di questi strumenti hanno una protezione integrata contro l’uso improprio, ma sul dark web vengono vendute soluzioni simili che non hanno tali restrizioni.

L’FBI raccomanda ai genitori di monitorare l’attività online dei propri figli e di parlare con loro più spesso dei rischi associati alla condivisione di file personali. Si consiglia agli adulti che pubblicano immagini e video online di limitarne l’accesso agli amici per ridurre i potenziali rischi. Allo stesso tempo, si consiglia di nascondere o mascherare sempre sfocando i volti dei bambini nelle foto e nei video.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…