Quante volte ci siamo imbattuti ad osservare una immagine, che altri utenti di Internet per divertimento spacciavano per qualcosa di assolutamente reale?

Recentemente, dei filmati e immagini delle conseguenze del terremoto del 2001 che non si sono mai verificati, oppure le foto dell’elegante Papa Francesco in un piumino imbottito, circolavano su Reddit in modo virale.

Le reti neurali aumentano la velocità e la qualità della generazione ogni mese, quindi è estremamente importante ora imparare a distinguere le foto reali dai falsi sfacciati.

Per semplificare il compito, alcune aziende promettono speciali servizi di rilevamento in grado di analizzare immagini dubbie utilizzando algoritmi complessi e formulare il proprio verdetto.

Ma quanto sono efficaci e affidabili tali servizi?

L’edizione americana del New York Times ha deciso di controllare alcuni di questi servizi come ad esempio “Illuminarty”, “AI or Not”, “Hive” e “Sensity”.

Per fare ciò, i ricercatori hanno “alimentato” i servizi con più di 100 fotografie, che raffiguravano vari paesaggi, strutture architettoniche, cibo, ritratti di persone e animali e molto altro. Molte delle immagini erano reali, ma il resto, ovviamente, è stato generato utilizzando reti neurali.

Per creare falsi realistici, i ricercatori hanno utilizzato generatori di intelligenza artificiale: Midjourney, Stable Diffusion e DALL-E .

I servizi stanno cercando schemi insoliti nella disposizione dei pixel, che spesso si verificano durante la generazione artificiale. Tuttavia, tali servizi non tengono conto del contesto e della logica dell’immagine, quindi a volte possono perdere falsi evidenti o scambiare una foto reale per un falso e viceversa.

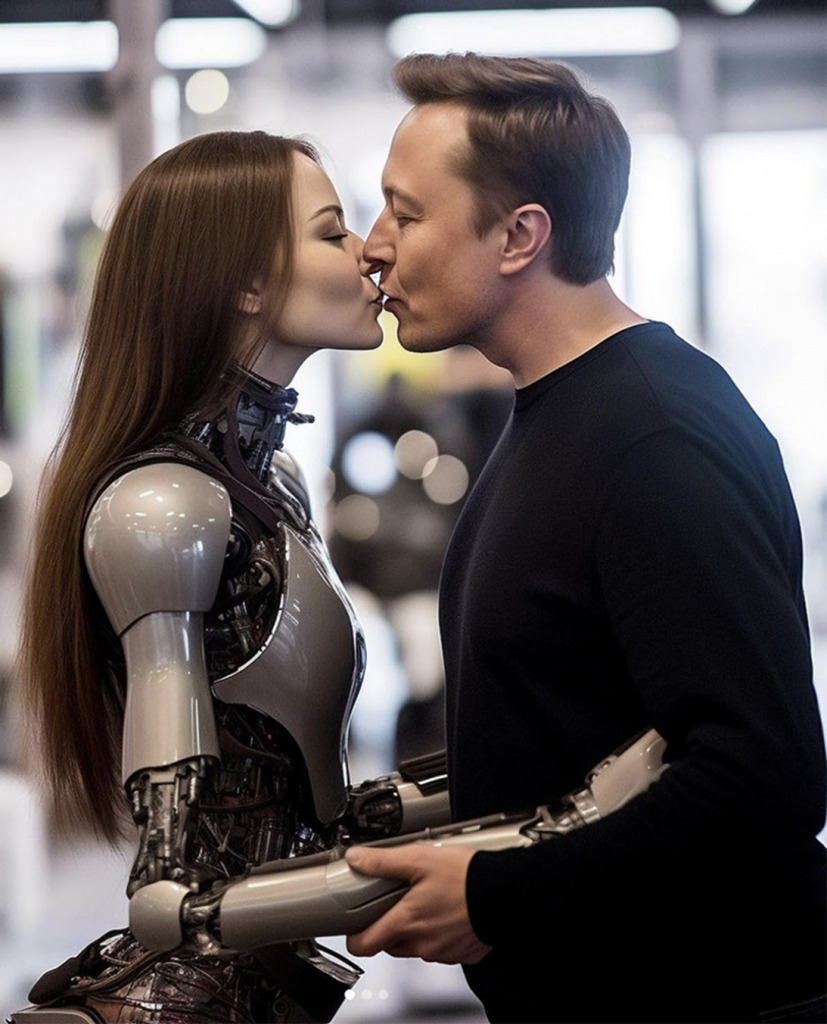

Ad esempio, una delle immagini verificate mostrava Elon Musk in compagnia di una realistica ragazza androide. L’immagine è stata creata utilizzando Midjourney, ma è riuscita a ingannare due dei cinque rilevatori facendogli credere che l’immagine fosse autentica.

Inoltre, i rilevatori AI hanno difficoltà con le immagini che sono state alterate rispetto al loro aspetto originale o sono di scarsa qualità.

Tali immagini si trovano spesso su Internet, dove vengono copiate, salvate nuovamente, ridotte o ritagliate. Tutto ciò influisce negativamente su quei marcatori su cui solitamente si basano i rilevatori di immagini generative.

Ad esempio, una delle immagini conteneva una foto molto vecchia di un gigantesco uomo di Neanderthal in piedi accanto a persone comuni.

Naturalmente, l’immagine è stata creata con Midjourney. Quando i rilevatori hanno analizzato l’immagine ad alta risoluzione, tutti l’hanno identificata correttamente come falsa, tuttavia, quando la qualità dell’immagine è stata intenzionalmente ridotta, tutti e cinque i rilevatori hanno riferito che l’immagine era autentica.

Oltre a una banale riduzione della qualità, l’aggiunta artificiale di rumore o grana digitale può aiutare a ingannare tali rilevatori, poiché le reti neurali di solito generano immagini “troppo perfette”.

I rilevatori hanno svolto un lavoro molto migliore nell’identificare le immagini reali.

Anche se a volte uno dei servizi potrebbe erroneamente considerare un’immagine di un artista astratto come opera di una rete neurale.

In generale, gli esperti ritengono che i rilevatori di intelligenza artificiale non dovrebbero essere l’unica difesa contro i contenuti falsi.

Suggeriscono di utilizzare anche altri metodi, come filigrane, avvisi online e restrizioni sulla distribuzione di immagini false. Chiedono inoltre maggiore trasparenza e responsabilità da parte dei creatori di tali contenuti e delle piattaforme su cui sono distribuiti.

L’intelligenza artificiale è in grado di generare non solo immagini realistiche, ma anche testi, audio e video, che possono essere utilizzati anche per manipolare l’opinione pubblica, i mercati finanziari e i processi politici.

Ciò crea nuove sfide e minacce per la società, che richiedono maggiore vigilanza e scetticismo nei confronti di qualsiasi contenuto Internet.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…

Cyber Italia

Cyber ItaliaNegli ultimi giorni è stato segnalato un preoccupante aumento di truffe diffuse tramite WhatsApp dal CERT-AGID. I messaggi arrivano apparentemente da contatti conosciuti e richiedono urgentemente denaro, spesso per emergenze come spese mediche improvvise. La…