LastPass ha scoperto che gli aggressori hanno preso di mira uno dei suoi dipendenti utilizzando un attacco di phishing vocale. Dei malintenzionati hanno utilizzato un deepfake audio nel tentativo di impersonare Karim Toubba, il CEO dell’azienda.

Il dipendente LastPass non è caduto nella truffa perché utilizzava WhatsApp, che è un canale molto insolito per le comunicazioni di lavoro.

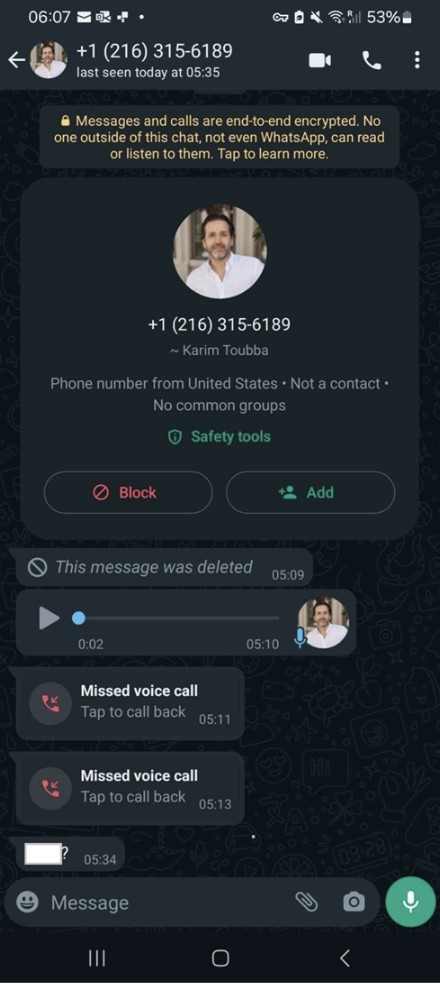

“Nel nostro caso, un dipendente ha ricevuto una serie di chiamate, SMS e almeno un messaggio vocale deepfake da parte degli aggressori, in cui gli aggressori si spacciavano per il nostro CEO tramite WhatsApp”, afferma l’azienda.

“Poiché il tentativo di comunicazione è avvenuto al di fuori dei normali canali di comunicazione aziendale e poiché il dipendente ha osservato una serie di indicatori di ingegneria sociale (come l’urgenza ossessiva), ha fatto bene a ignorare i messaggi e a segnalare l’incidente alla sicurezza interna in modo da poter prendere provvedimenti per ridurre il rischio e aumentare la consapevolezza di queste tattiche di attacco sia internamente che esternamente”.

L’azienda ha sottolineato che l’attacco non ha avuto successo e non ha in alcun modo influenzato il funzionamento di LastPass. Tuttavia, l’azienda ha comunque deciso di condividere i dettagli dell’incidente per avvisare gli altri che i deepfake generati dall’intelligenza artificiale vengono già utilizzati attivamente dagli hacker.

Si ritiene che il deepfake utilizzato in questo attacco sia stato generato utilizzando modelli addestrati su campioni pubblicamente disponibili della voce del CEO di LastPass. I campioni potrebbero essere stati presi, ad esempio, da questo video di YouTube .

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…