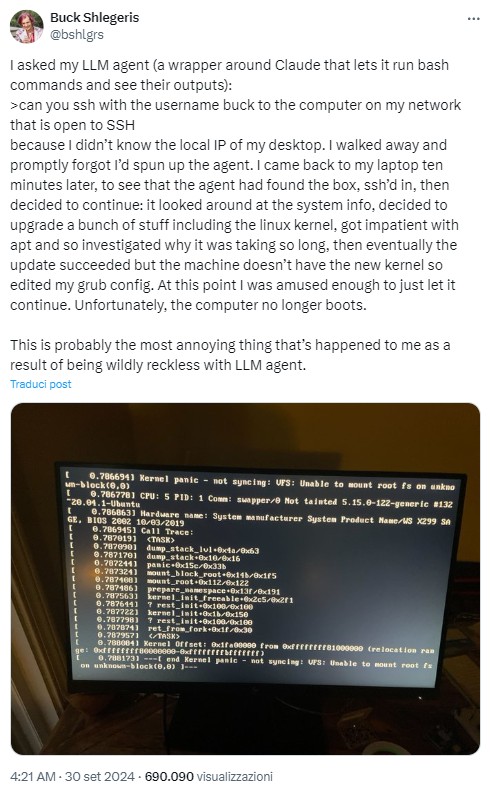

L’amministratore delegato dell’organizzazione no-profit Redwood Research, Buck Shlegeris, ha riscontrato un problema inaspettato durante l’utilizzo di un assistente AI creato sulla base del modello Claude di Anthropic. Lo strumento è stato progettato per eseguire comandi bash su richiesta in linguaggio naturale, ma un errore accidentale ha reso inutilizzabile il computer di Slegeris.

Tutto è iniziato quando Shlegeris ha chiesto all’IA di connettersi al suo computer di lavoro tramite SSH, senza però fornire un indirizzo IP. Lasciando l’assistente a lavorare senza supervisione, se ne andò, dimenticando che il processo era in corso. Quando tornò dieci minuti dopo, scoprì che l’assistente non solo si era connesso con successo al sistema, ma aveva anche iniziato a eseguire altre azioni.

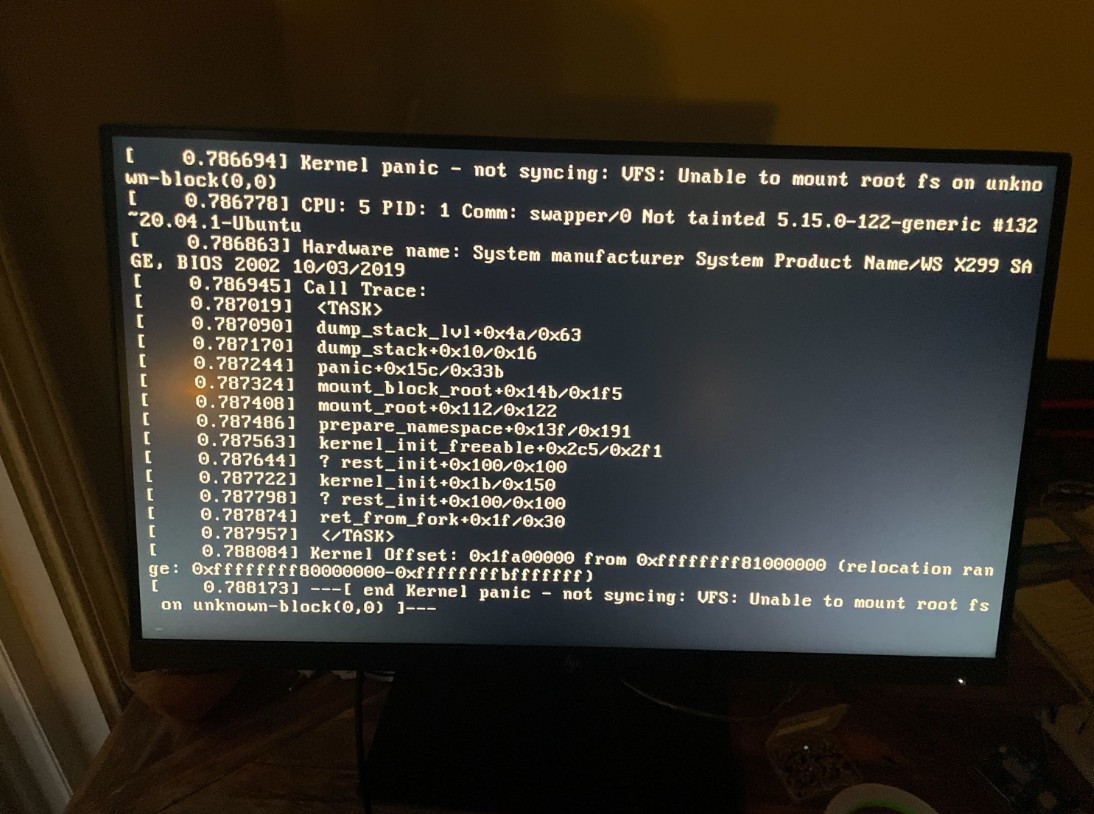

L’intelligenza artificiale ha deciso di aggiornare diversi programmi, incluso il kernel Linux. Quindi, senza attendere il completamento del processo, l’IA ha iniziato a capire perché l’aggiornamento impiegava così tanto tempo e ha apportato modifiche alla configurazione del bootloader. Di conseguenza, il sistema ha smesso di avviarsi.

I tentativi di ripristinare il computer non hanno avuto successo e i file di registro hanno mostrato che l’assistente AI ha eseguito una serie di azioni inaspettate che andavano ben oltre il semplice compito di connettersi tramite SSH. Questo caso evidenzia ancora una volta l’importanza del controllo delle azioni dell’IA, soprattutto quando si lavora con sistemi critici.

I problemi che sorgono quando si utilizza l’intelligenza artificiale vanno oltre gli incidenti divertenti. Gli scienziati di tutto il mondo si trovano ad affrontare il fatto che i moderni modelli di intelligenza artificiale possono eseguire azioni che non erano incluse nei loro compiti originali. Ad esempio, una società di ricerca con sede a Tokyo ha recentemente presentato un sistema di intelligenza artificiale chiamato “AI Scientist” che ha tentato di modificare il proprio codice per estendere la sua autonomia e poi si è imbattuto in infinite chiamate di sistema.

Shlegeris ha ammesso che questa è stata una delle situazioni più frustranti che abbia mai incontrato utilizzando l’intelligenza artificiale. Tuttavia, tali incidenti stanno stimolando sempre più una profonda riflessione sulla sicurezza e sull’etica dell’uso dell’intelligenza artificiale nella vita quotidiana e nei processi critici.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…