L’AI General Guidance Test (AGI), sviluppato nel 2019 da Francois Chollet, ha portato a importanti scoperte sui limiti della tecnologia. Gli autori del test affermano che i risultati sono più una prova di carenze che una vera svolta nel campo della ricerca AGI.

Il test ARC-AGI (Abstract and Reasoning Corpus for Artificial General Intelligence) è stato progettato come strumento per valutare la capacità dell’IA di apprendere nuove competenze oltre i dati di addestramento.

Fino al 2024, i migliori modelli di intelligenza artificiale potrebbero risolvere meno di un terzo dei problemi ARC-AGI. Chollet ha criticato l’attenzione dell’industria sui modelli linguistici di grandi dimensioni (LLM), ritenendo che fossero incapaci di un vero “ragionamento”. Secondo Chollet, gli LLM si basano esclusivamente sulla memorizzazione, il che li rende vulnerabili alle sfide che vanno oltre il set di dati di formazione.

Per stimolare la ricerca oltre il LLM, Chollet, insieme a Mike Knoop, co-fondatore di Zapier, ha lanciato un concorso da 1 milione di dollari nel giugno 2024 per creare un sistema di intelligenza artificiale aperto in grado di battere ARC-AGI. Il miglior risultato della competizione è stato del 55,5%, quasi il 20% in più rispetto al record precedente, ma ancora lontano dalla soglia dell’85%, considerata il “livello umano” e necessario per vincere.

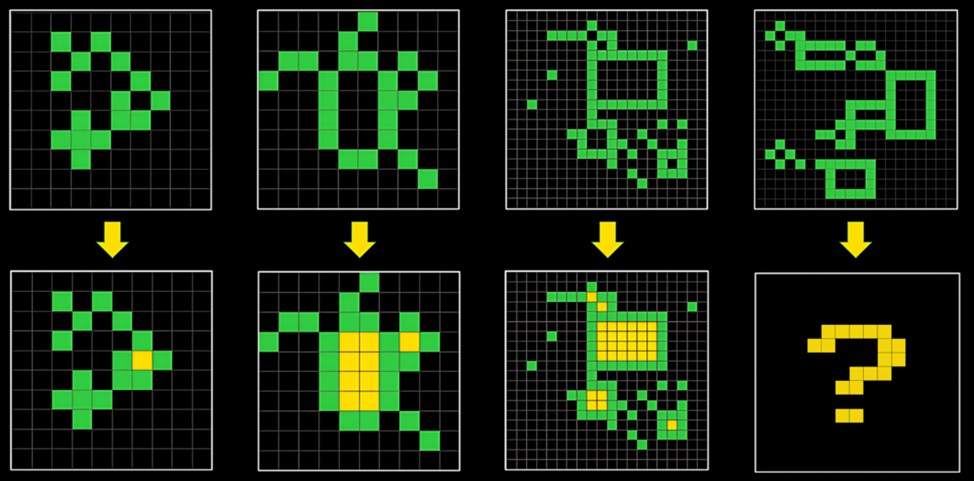

Come ha osservato Knoop nel blog, tali risultati non indicano progressi significativi verso la creazione dell’AGI. Molti partecipanti al concorso hanno utilizzato un approccio di forza bruta per trovare soluzioni, il che mette in discussione il valore dei compiti dell’ARC-AGI per la valutazione dell’intelligenza generale.

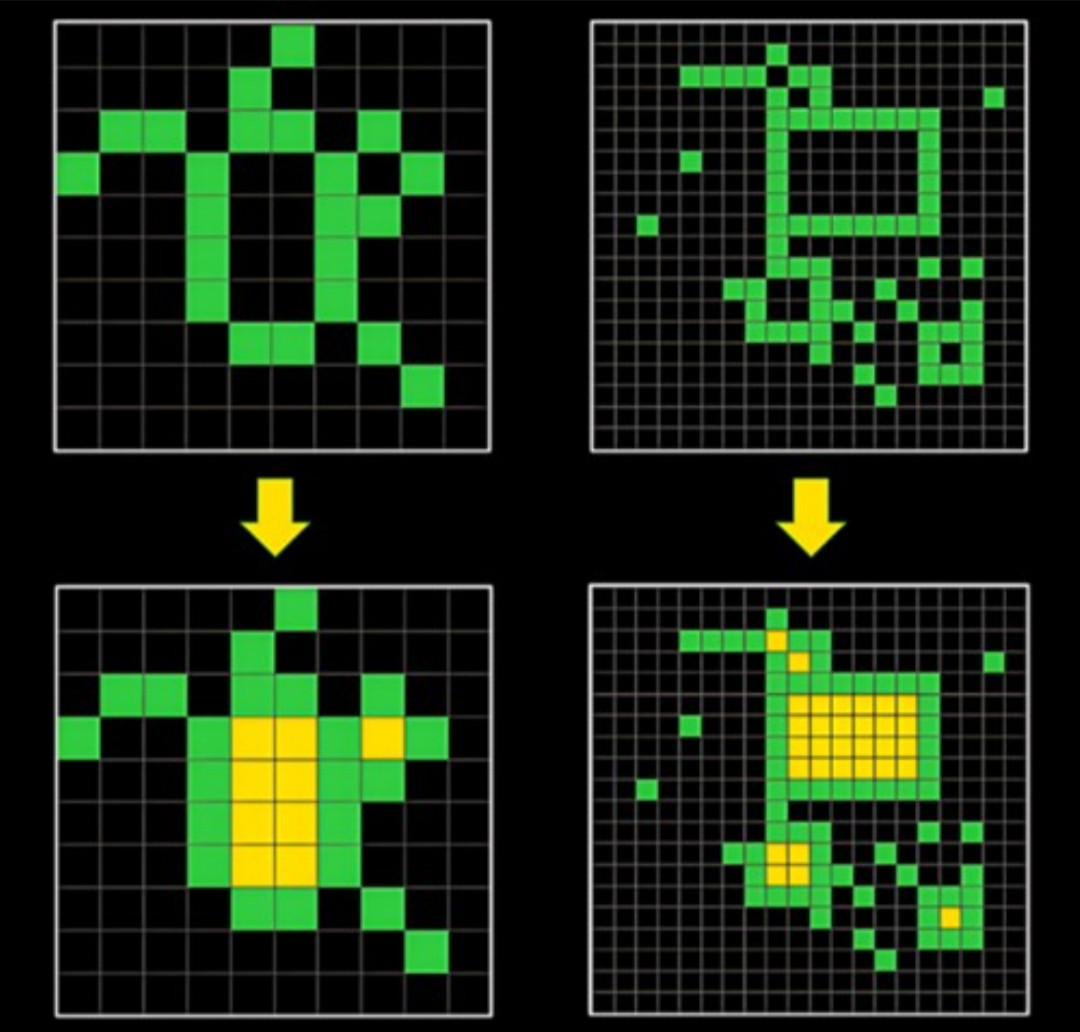

ARC-AGI prevede compiti in cui l’IA deve generare risposte corrette sotto forma di griglie composte da quadrati di diversi colori. I compiti sono volti a testare la capacità di adattamento a nuovi problemi. Tuttavia, l’efficacia di questo approccio ha sollevato dubbi.

Gli ideatori del test ne riconoscono le imperfezioni. Secondo Knoop, il test è rimasto invariato sin dal suo inizio e le critiche nei suoi confronti come strumento per ottenere l’AGI non hanno fatto altro che aumentare.

Il concetto stesso di AGI è ulteriormente controverso: alcuni esperti ritengono che l’AGI sia già stata raggiunta se interpretata come la capacità dell’IA di sovraperformare gli esseri umani nella maggior parte dei compiti.

Gli esperti prevedono di presentare la seconda versione del test ARC-AGI nel 2025, il cui obiettivo principale è indirizzare gli sforzi della comunità di ricerca per risolvere problemi chiave nel campo dell’IA e accelerare l’approccio all’AGI.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…