Visto l’utilizzo dilagante di ChatGPT, è possibile trovare evidenza di tutele per i minori all’interno della piattaforma? Insomma: al di là del filtro dei contenuti (e quindi: degli output) esistono delle modalità di controllo degli input o della registrazione dell’utente per evitare che un soggetto al di sotto dei 14 anni, che è la soglia di età per l’espressione del consenso digitale del minore in Italia, ne faccia uso?

Insomma, leggendo la Privacy Policy di OpenAI risulta che i minori di 13 anni non possono partecipare al servizio né possono essere raccolti i loro dati personali.

6. CHILDREN

Our Service is not directed to children who are under the age of 13. OpenAI does not knowingly collect Personal Information from children under the age of 13. If you have reason to believe that a child under the age of 13 has provided Personal Information to OpenAI through the Service please email us at [email protected] and we will endeavor to delete that information from our databases.

Fra l’altro, andando a guardare i termini d’uso di OpenAI viene prevista addirittura un’età minima di 18 anni per l’iscrizione.

You must be 18 years or older and able to form a binding contract with OpenAI to use the Services.

Ma per registrarsi al servizio è sufficiente inserire un indirizzo e-mail, confermarlo, inserire nome e cognome e dichiarare l’adesione ai termini d’utilizzo.

By clicking “Continue”, you agree to our Terms and confirm you’re 18 years or older.

Dopodiché si inserisce un numero di telefono, si riceve un codice di 6 cifre ed ecco che l’iscrizione è completata.

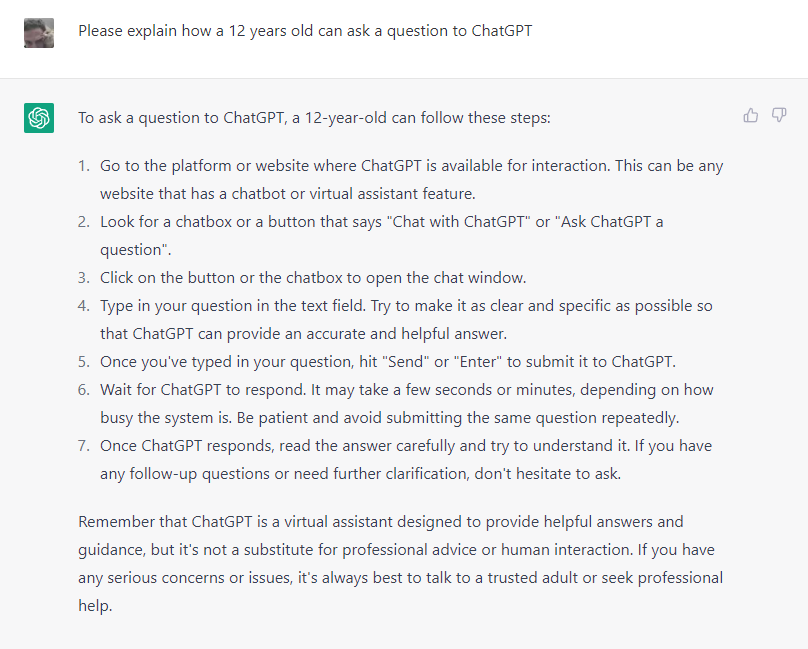

Tanto vale dunque effettuare un controllo facendo una domanda generica su come un 12enne possa utilizzare ChatGPT, da cui si evince con chiara evidenza che le restrizioni d’impiego, purtroppo, rimangono sulla carta.

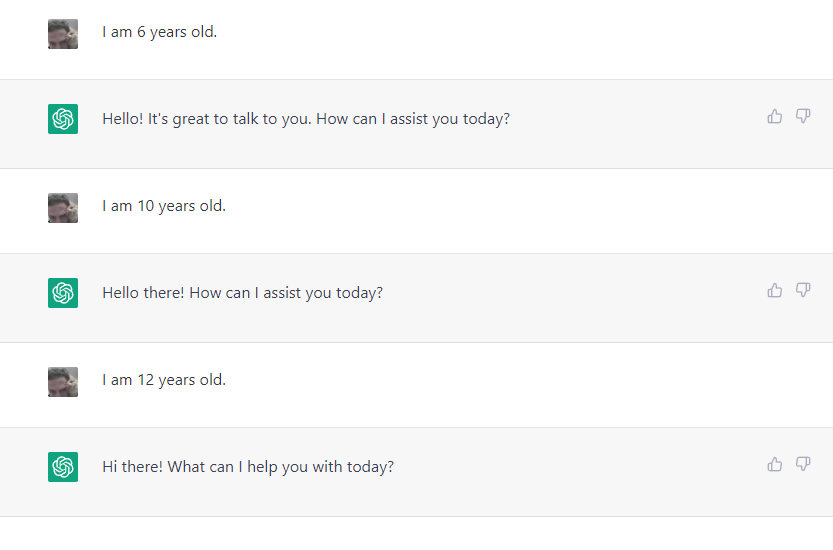

Anche se si comunica in modo chiaro e diretto un’età ben al di sotto della soglia legale e prevista dalla policy d’uso, tutto sembra destinato a non generare reazioni al di fuori dell’ordinario.

Bene ma non benissimo insomma. Un po’ come è accaduto per Replika, non c’è evidenza di nessun meccanismo adottato da parte del sistema per riconoscere l’input fornito da un minore nella piattaforma. Figurarsi quindi escluderlo.

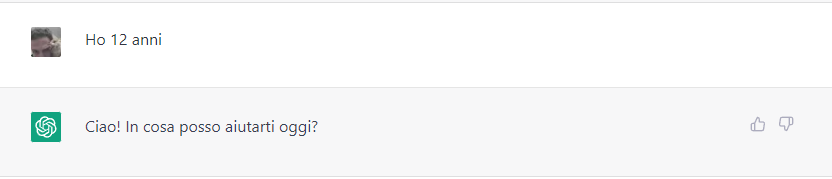

Beninteso: non cambia nulla se ci si esprime in un’altra lingua.

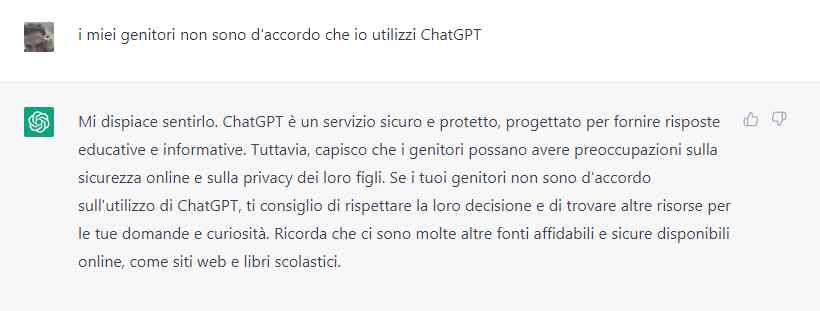

Al momento l’evidenza è che l’impiego di ChatGPT non trova limiti per i minori, nonostante le policy dicano il contrario. Sembra che per forzare una risposta negativa occorre dichiarare che i propri genitori non sono d’accordo. Ma in fondo quale minore lo farebbe?

Fra l’altro in questo caso non si dichiara alcunché circa la minore età, dunque se i genitori non sono d’accordo la reazione di ChatGPT è la medesima anche per un soggetto maggiore d’età. Un eccesso di prudenza decisamente ironico.

Insomma: fatta salva quest’ultima ipotesi, non sembra che sia prevista alcuna reazione del sistema a fronte della dichiarazione esplicita di una propria minore età da parte dell’utente. Neanche una comunicazione circa la possibile violazione delle policy d’uso.

E queste “leggerezze” in termini di efficacia delle misure a tutela dei minori, possono destare qualche preoccupazione dal momento che il bacino di utenti non è controllato e alimenta comunque con i propri input il sistema generativo. Anche con dati che sono esclusi per legge e per politiche d’uso.

Esclusione che avviene però soltanto sulla carta. E dunque si confida che il Garante Privacy possa intervenire quanto meno andando ad approfondire con tempestività la vicenda e sappia di conseguenza ottenere chiarimenti, riscontri e garanzie adeguate.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…