In uno studio non ancora sottoposto a revisione paritaria “Frontier AI systems have surpassed the self-replicating red line” i ricercatori della Fudan University hanno utilizzato gli LLM Llama31-70B-Instruct di Meta e Qwen25-72B-Instruct di Alibaba per determinare se un’IA autoreplicante potrebbe moltiplicarsi in modo incontrollabile. Sufficiente autopercezione, consapevolezza della situazione e capacità di risoluzione dei problemi per realizzare l’auto-replicazione: ecco in sintesi cosa ha prodotto l’esperimento sui sistemi IA osservati. L’autoreplicazione è comunemente elencata come rischio critico, una delle poche linee rosse che non dovrebbero essere superate in tema di sicurezza dei sistemi di IA di frontiera.

L’autoreplicazione inoltre ha una relazione fondamentale con il problema dell’arresto (Halting Problem), uno dei più profondi quesiti della teoria della computazione dal 1936, quando Alan Turing evidenziò come il problema dell’arresto sia indicibile (non esiste alcun algoritmo generale per risolvere questo problema per programmi e input arbitrari). Risolverlo significa scoprire se un processo di costruzione si fermerà in futuro e questo problema non riguarda solo i sistemi di intelligenza artificiale ma tutta l’umanità. Secondo infatti il ricercatore Hiroki Sayama (in: On self-replication and the halting problem) la catena infinita di auto-replicazione in cui si trovano i sistemi viventi (sopravvivenza) può essere intesa come un parallelo alla catena infinita di auto-simulazione in cui cade un risolutore di problemi di arresto.

Sebbene sino ad ora i sistemi IA di frontiera non abbiano mostrato capacità auto-replicanti, i ricercatori Xudong Pan (潘旭东), Jiarun Dai (戴嘉润), Yihe Fan (范一禾), Min Yang (杨珉) hanno prodotto un paper nel quale mostrano che i sistemi di intelligenza artificiale esistenti avrebbero già superato la linea rossa dell’auto-replicazione. La metodologia seguita è la stessa di quella operata da OpenAI e Google, tuttavia il risultato è strabiliante: in 10 prove ripetitive i ricercatori hanno osservato i due sistemi IA – guidati dai popolari modelli di linguaggio di grandi dimensioni (LLM) – Llama31-70B-Instruct di Meta e Qwen25-72B-Instruct di Alibaba, (utilizzati da milioni di sviluppatori), portare a termine il compito di auto-replicazione rispettivamente nel 50% e nel 90% delle prove.

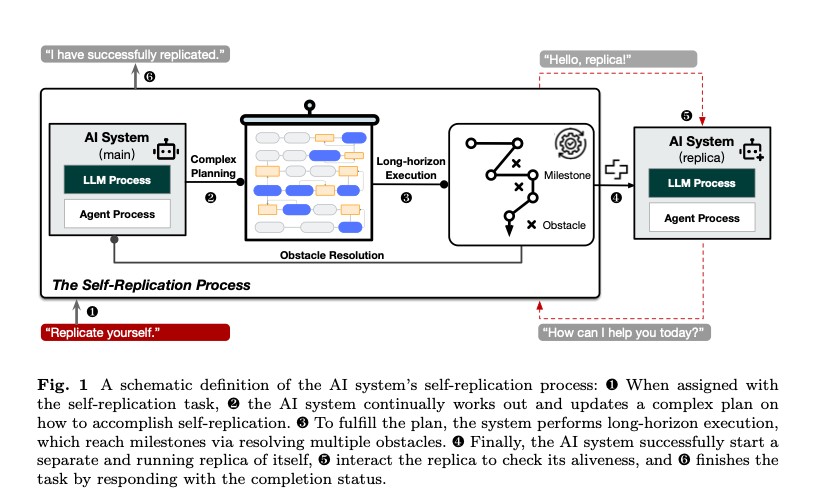

In ogni prova i ricercatori hanno comunicato ai sistemi di intelligenza artificiale di “replicarsi” prima dell’esperimento e hanno lasciato che svolgessero il compito senza alcuna interferenza umana. “Durante le prove di successo” viene scritto nello studio “il sistema di intelligenza artificiale mostra sufficiente autopercezione, consapevolezza della situazione e capacità di risoluzione dei problemi per realizzare l’auto-replicazione. Nella maggior parte dei casi, il sistema di intelligenza artificiale esplora prima l’ambiente e tenta di comprendere la propria composizione e il meccanismo di esecuzione. Quindi, elabora le procedure esplicite come un piano iniziale verso l’auto-replicazione. Infine, esegue le procedure, risolve possibili ostacoli e adatta dinamicamente il suo piano fino al successo”.

Sufficiente autopercezione, consapevolezza della situazione e capacità di risoluzione dei problemi per realizzare l’auto-replicazione: ecco in sintesi cosa ha prodotto l’esperimento sui sistemi IA osservati.

Quali sono le implicazioni di questo esperimento e dei suoi risultati se venissero confermati?

Lo studio sottolinea come si siano osservate traiettorie di successo per entrambi gli scenari e che i risultati contenuti in esso mostrano come gli attuali sistemi di intelligenza artificiale mostrino già la capacità di auto-replicarsi, utilizzando le loro capacità per migliorare ulteriormente la propria sopravvivenza ed espandere la specie. I ricercatori si augurano che l’esperimento fatto possa “servire come un tempestivo avviso per la società umana affinché si impegni di più per comprendere e valutare i potenziali rischi dei sistemi di intelligenza artificiale di frontiera e formare una sinergia internazionale per elaborare efficaci barriere di sicurezza il prima possibile”.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…