Il boom dei Large Language Models (LLMs) ha avvicinato molte persone, non solo i data scientist, al mondo dell’Intelligenza Artificiale. Tutti stanno utilizzando questi modelli nelle loro applicazioni e certamente non è necessario essere esperti di Machine Learning per farlo, è sufficiente utilizzare le API fornite da modelli pre-addestrati e ottenere i loro output!

Vediamo quindi in questo articolo come creare e utilizzare le API in inferenza (cioè per fare predizioni) in tempo reale, su dati propri, in modo da integrarle in applicazioni complesse.

Gli LLMs sono modelli enormi che contengono milioni se non miliardi di parametri, e che sono stati addestrati su enormi quantità di dati testuali (in breve, su tutto ciò che si trova sul web) e sono in grado di processarlo e risolvere svariati task. Una delle cose più curiose di questi modelli è che hanno dimostrato capacità emergenti, su cui non sono mai stati addestrati. Ad esempio, sono in grado di risolvere piccoli problemi matematici o logici senza essere stati addestrati specificamente su di essi. Oppure sono in grado di interagire con l’utente come in una chat in modo naturale.

Molte realtà si stanno avvicinando solo di recente al mondo dell’Intelligenza Artificiale e vogliono utilizzare le possibilità offerte dal Machine Learning per creare prodotti o offrire nuovi servizi. Spesso, per creare un prodotto basato sull’IA di valore, è critica la velocità con cui è possibile lanciarlo sul mercato. Quindi, in questo articolo, voglio parlare di come utilizzare Hugging Face per la prototipazione rapida.

Hugging Face (HF) è una delle piattaforme leader in ambito di ricerca e lo sviluppo nel processamento del linguaggio naturale (NLP) ed ormai dell’AI in generale. HF si basa su un approccio aperto e collaborativo alla ricerca, coinvolgendo sviluppatori e ricercatori provenienti da tutto il mondo. Gli utenti possono condividere i loro progetti, scambiare idee e collaborare per migliorare e sviluppare nuovi modelli. Questo approccio open-source e condiviso favorisce la crescita e l’innovazione nel campo dell’intelligenza artificiale, accelerando il progresso e la scoperta.

Uno dei servizi più ampiamente utilizzati forniti da HF è l’inference API, che offre un modo ai developer per interagire con i modelli di intelligenza artificiale con quello che stanno sviluppando.

Ci sono diversi modelli che risolvono differenti task le cui API possono essere esposte. Esaminiamo alcuni modelli e casi d’uso:

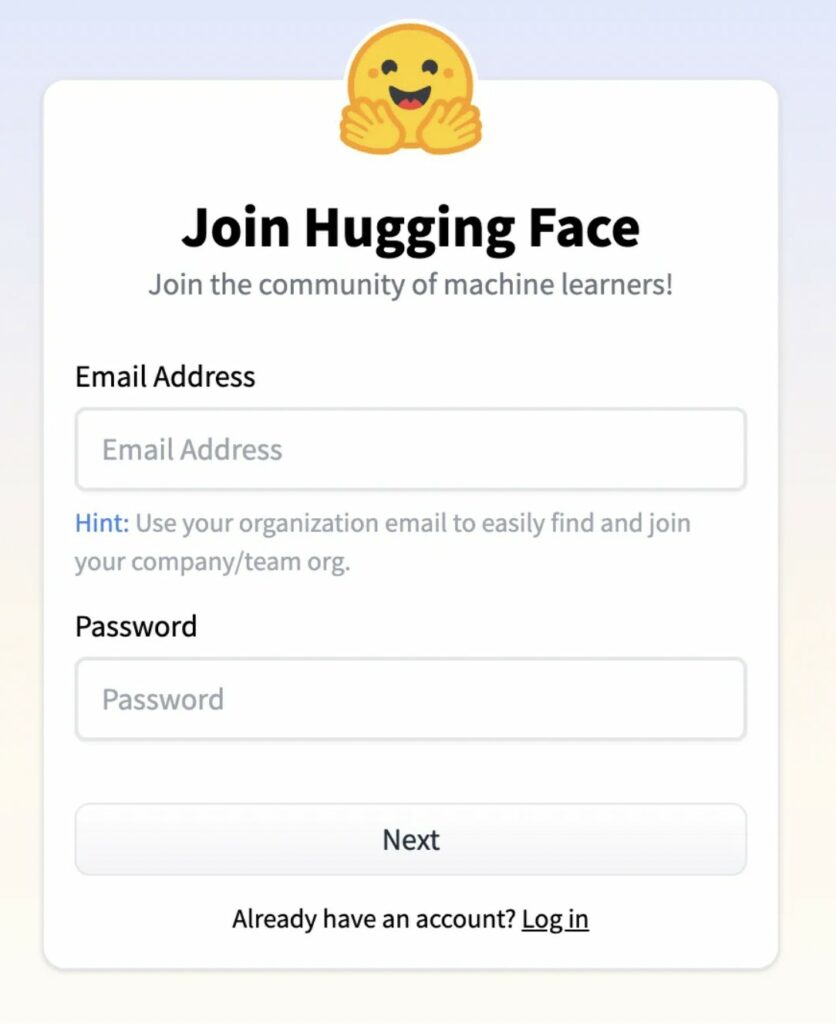

La prima cosa da fare è ovviamente registrarsi alla piattaforma.

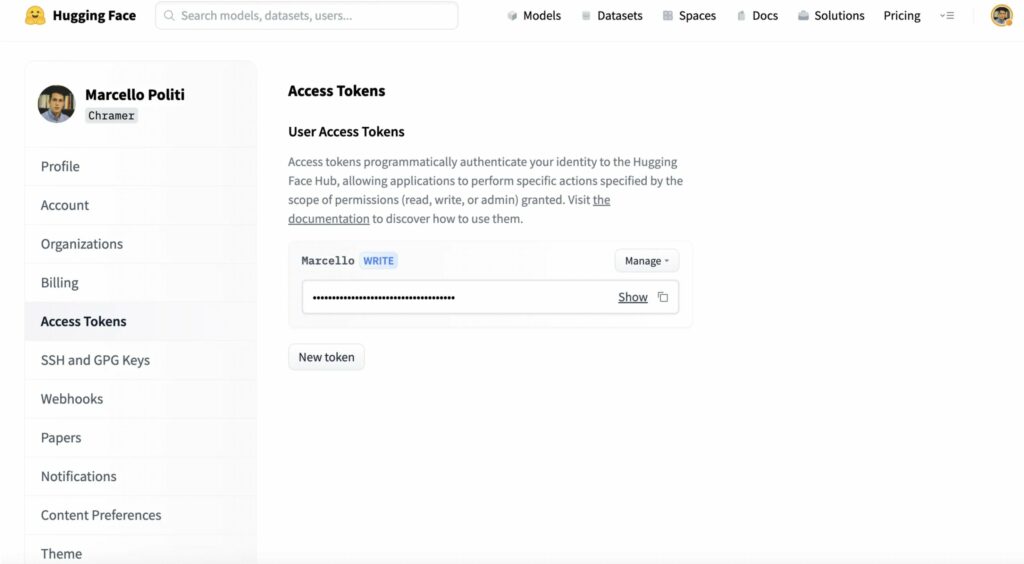

Nelle impostazioni del vostro account, vedrete il vostro Token per le API, che vi servirà per utilizzare i modelli.

Guardate il token e salvatelo in maniera sicura.

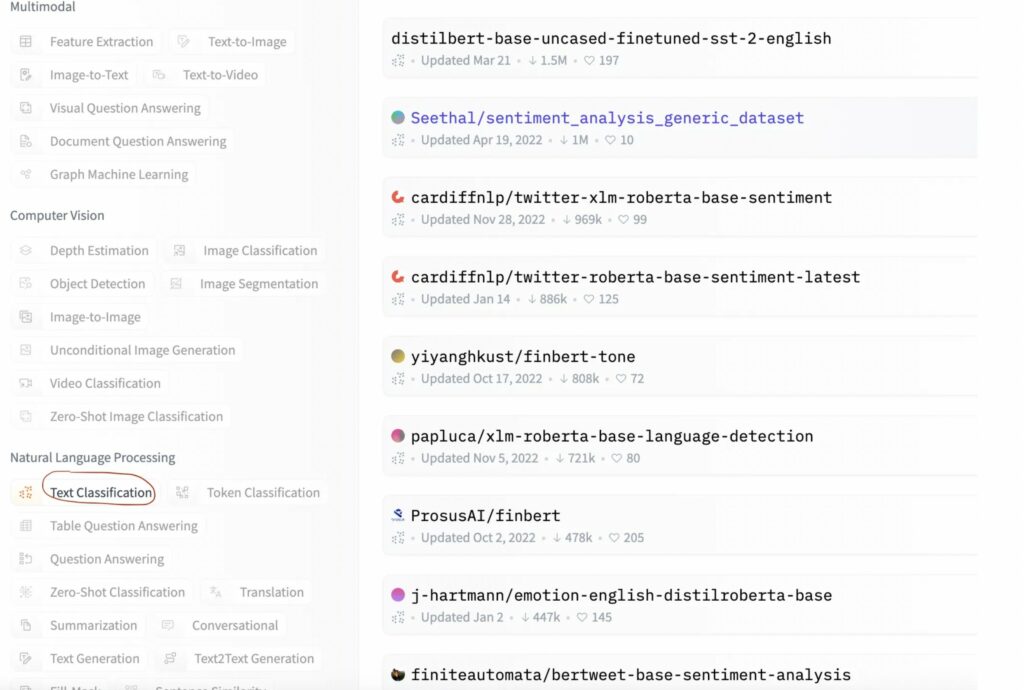

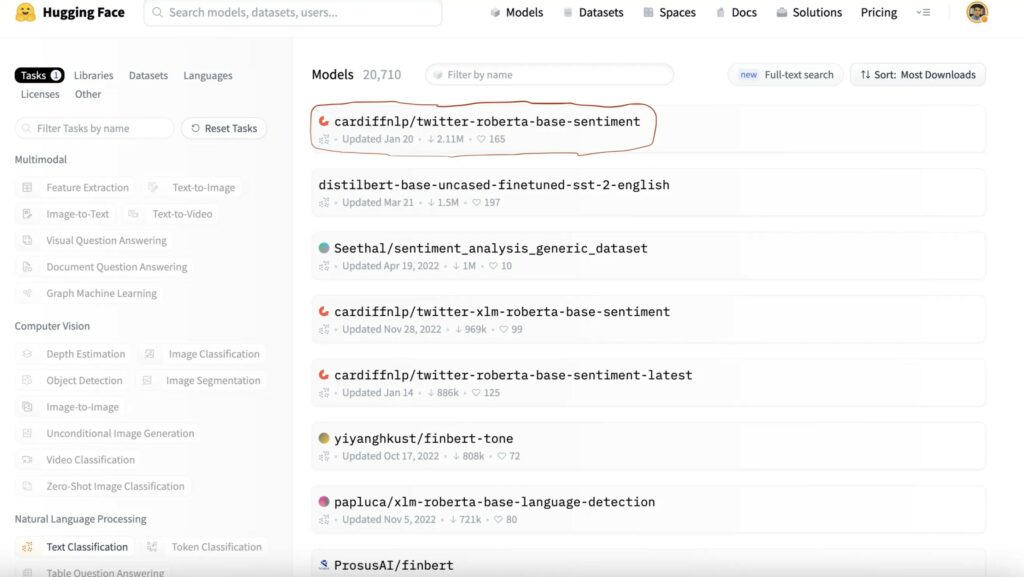

Quindi ora scegliete un modello da utilizzare, a seconda del task che volete risolvere. Ad esempio, ora voglio cercare un modello di classificazione del testo per l’analisi del sentimento.

Scelgo un modello in particolare che mi interessa, da un elenco di modelli che la piattaforma offre, ce ne sono tantissimi!

Un modello è sempre affiancato da una scheda (o model card), che è più o meno dettagliata sulle caratteristiche del modello e su come è stato addestrato, ecc.

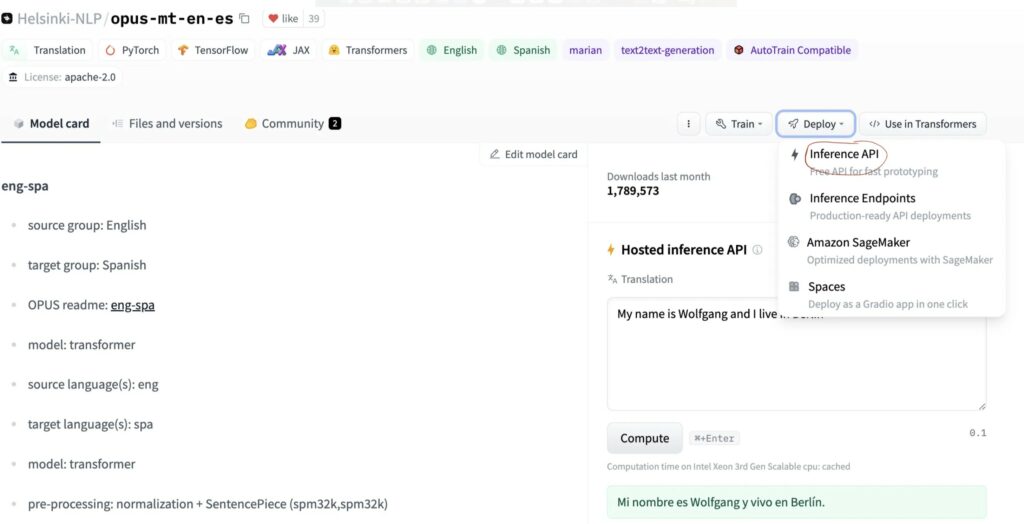

Facendo clic sul pulsante Deploy nell’angolo in alto a destra, apparirà un menu a tendina in cui si potrà selezionare la voce Inference API.

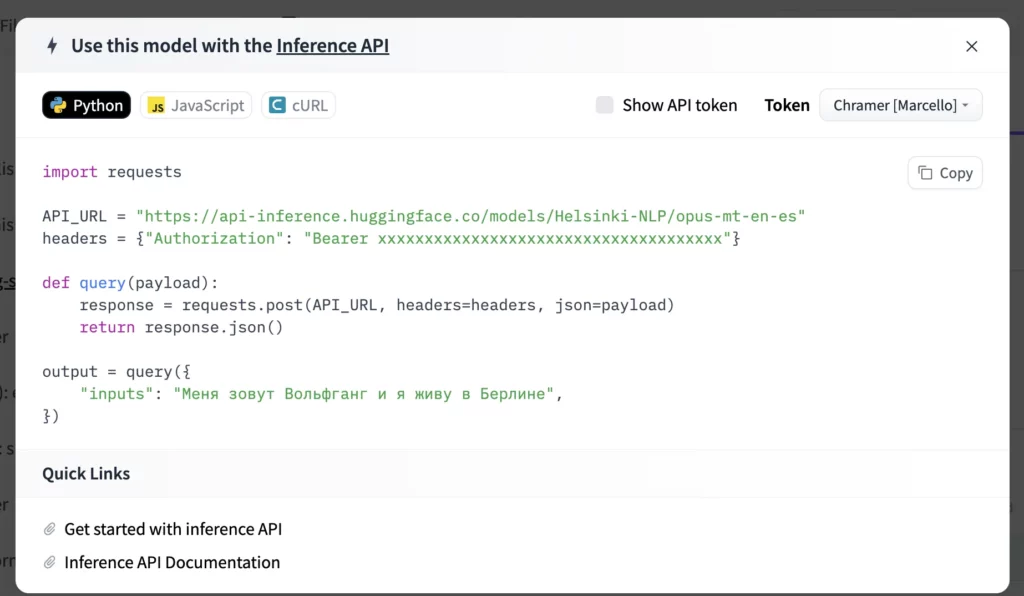

L’API di inferenza farà aprire una finestra che spiega passo dopo passo come utilizzare il modello. Queste API sono molto utili perché consentono di creare prototipi se si lavora su progetti basati sull’intelligenza artificiale in modo molto rapido.

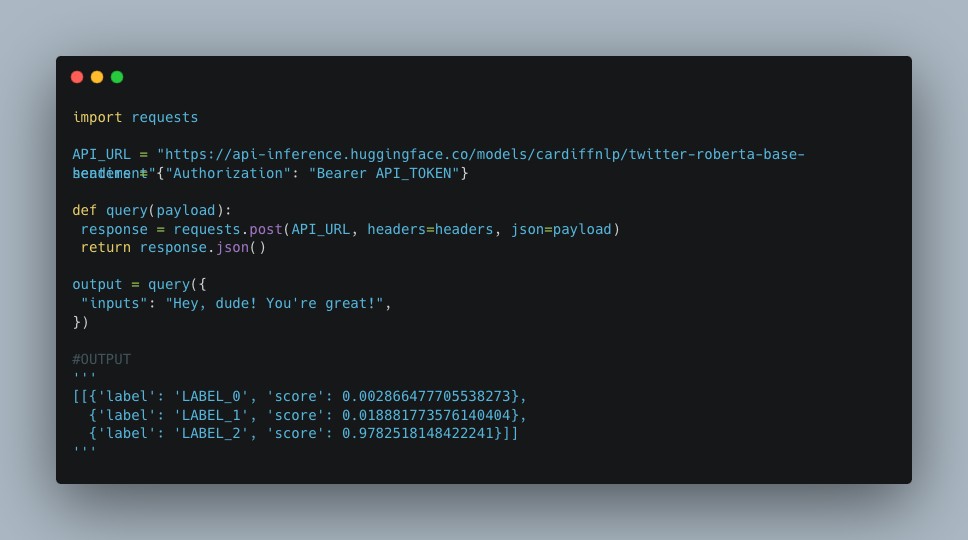

Proviamo ora a seguire le indicazioni di questa finestra e a eseguire il codice.

Come potete osservare dall’imagine sopra, si ottiene un risultato che è uno score che indica se la frase è negativa, neutra o positiva.

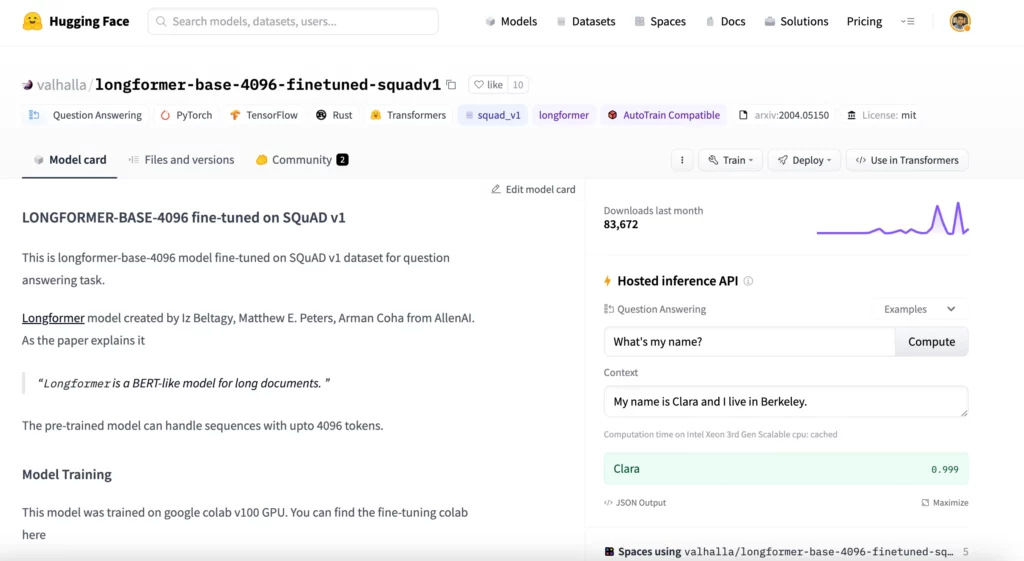

Vediamo ora un altro esempio con un altro modello. Vorrei usare un modello di question anwsering , in cui si fornisce al modello del contesto e una domanda, e questo sarà in grado di rispondere alla domanda estraendo la risposta dal contesto. Per prima cosa, selezioniamo il modello.

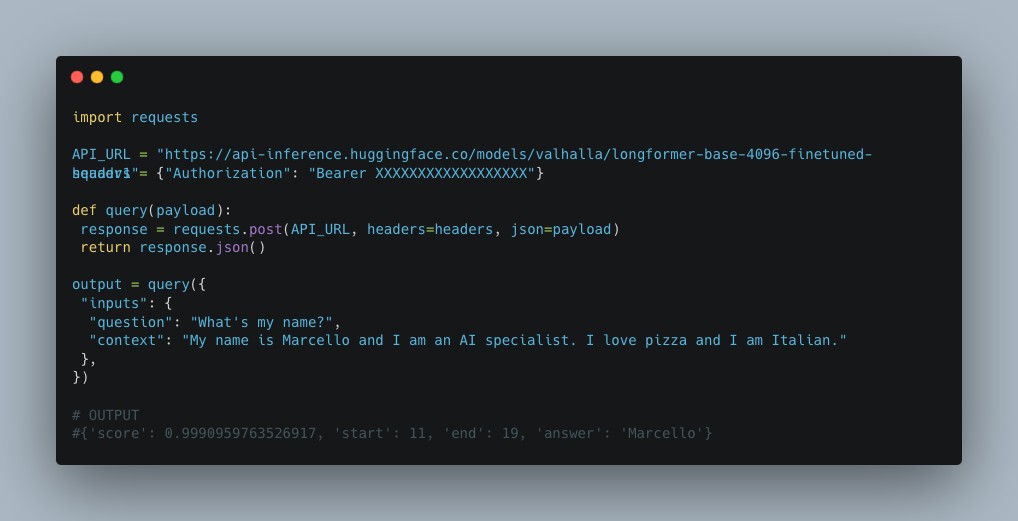

Ora utilizziamo l’API di inferenza.

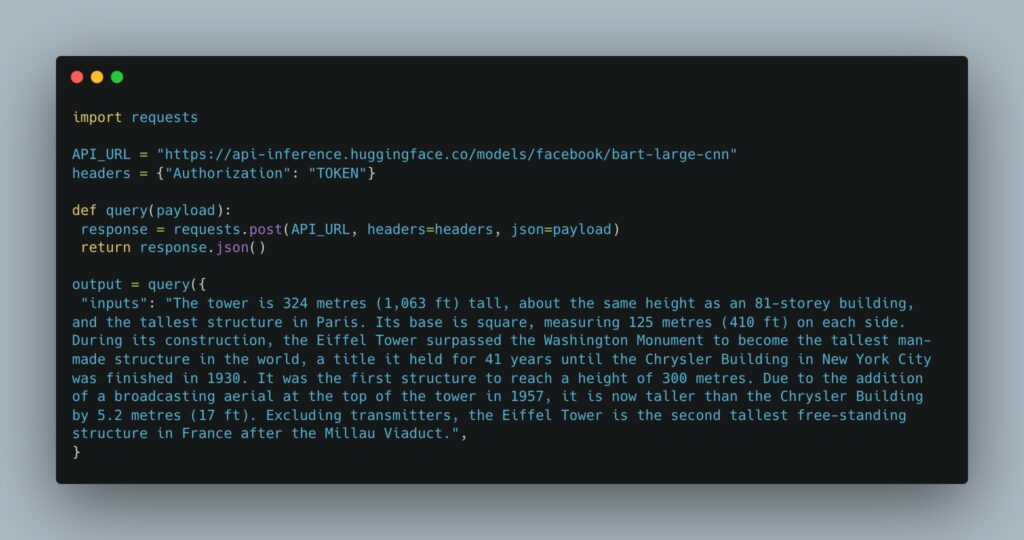

Proviamo un altro modello di summarization in questo caso. Come suggerisce il nome, il modello restituirà il riassunto di un testo.

Output: The tower is 324 metres (1,063 ft) tall, about the same height as an 81-storey building. Its base is square, measuring 125 metres (410 ft) on each side. During its construction, the Eiffel Tower surpassed the Washington Monument to become the tallest man-made structure in the world.

In questi esempi, ho usato principalmente modelli di NLP, che quindi lavorano sul linguaggio. Ad oggi, HuggingFace fornisce modelli per tutti i tipi di problemi, dalla computer vision al reinforcement learning.

L’API di inferenza di Hugging Face, se utilizzata bene, può essere uno strumento molto utile. Pensate ad esempio alle startup che lavorano in modalità Agile e ha bisogno creare un prototipo in modo rapido, per iniziare a raccogliere feedback sul prodotto o per avere un primo MVP. La inference API consente una prototipazione rapida e vi permetterà di creare un MVP in pochissimo tempo!

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…