Di Alter3 ne avevamo parlato recentemente. Si tratta di una versione più recente del robot umanoide introdotto per la prima volta nel 2016.

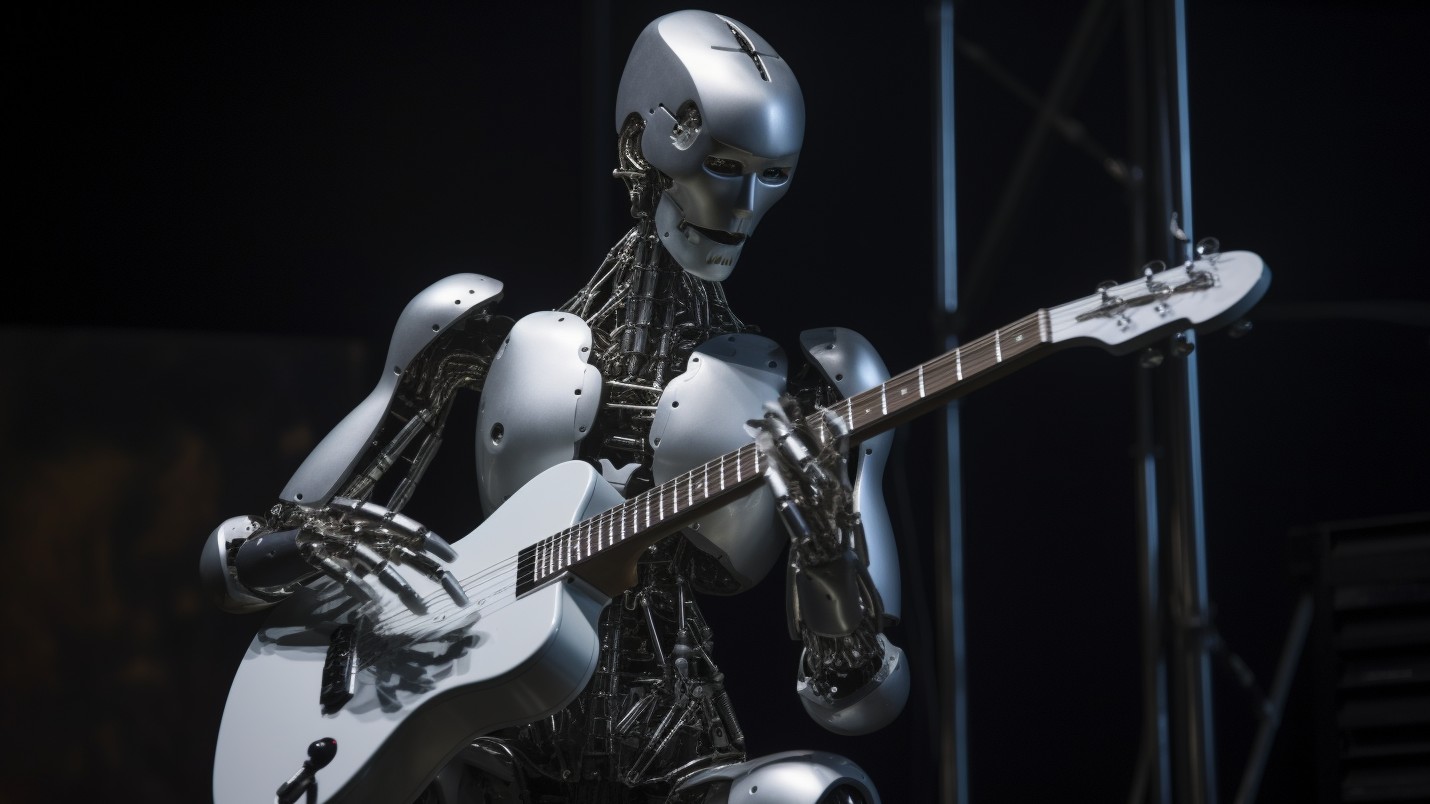

Un team di ricercatori dell’Università di Tokyo ha utilizzato GPT-4 per guidare il robot attraverso varie simulazioni, come scattare selfie, lanciare una palla, mangiare popcorn e mimare di suonare una chitarra elettrica Metal. Lo riporta TechXplore.

In precedenza, ogni azione richiedeva una codifica speciale, ma l’inclusione di GPT-4 apre nuove possibilità per i robot che apprendono attraverso istruzioni in linguaggio naturale. Il controllo diretto è ora possibile mappando le espressioni linguistiche delle azioni umane utilizzando il codice software, spiegano gli scienziati. Hanno chiamato questo risultato un “cambiamento di paradigma”.

In grado di eseguire movimenti complessi della parte superiore del corpo, comprese espressioni facciali dettagliate, Alter3 ha 43 assi che imitano il sistema muscolo-scheletrico umano. Sta su un supporto, ma non può camminare (anche se può imitare il cammino).

Codificare la coordinazione di un numero così elevato di articolazioni è stato un compito arduo che comportava movimenti ripetitivi. Grazie al modello linguistico (LLM) tutto sembra essere cambiato.

Gli scienziati ora possono semplicemente fornire istruzioni verbali che descrivono i movimenti desiderati e fornire suggerimenti per il LLM. Il modello linguistico a sua volta genera codice Python che esegue il motore Android.

Alter3 ricorda le azioni in modo che i ricercatori possano perfezionarle e regolarle, ottenendo movimenti più rapidi, fluidi e precisi nel tempo.

Gli autori forniscono un esempio di istruzioni in linguaggio naturale fornite da Alter3 per scattare un selfie:

I ricercatori non hanno perso l’occasione di prendersi gioco del robot. In uno scenario, il robot finge di mangiare un sacchetto di popcorn e poi apprende che il popcorn appartiene alla persona seduta accanto ad esso. Le espressioni facciali e i gesti esagerati delle mani trasmettono sorpresa e imbarazzo.

Dotato di una telecamera, Alter3 può “vedere” le persone. I ricercatori hanno scoperto che Alter3 affina il suo comportamento osservando le reazioni di una persona. Hanno paragonato questo apprendimento all’imitazione neonatale che i comportamentisti infantili osservano nei neonati.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.