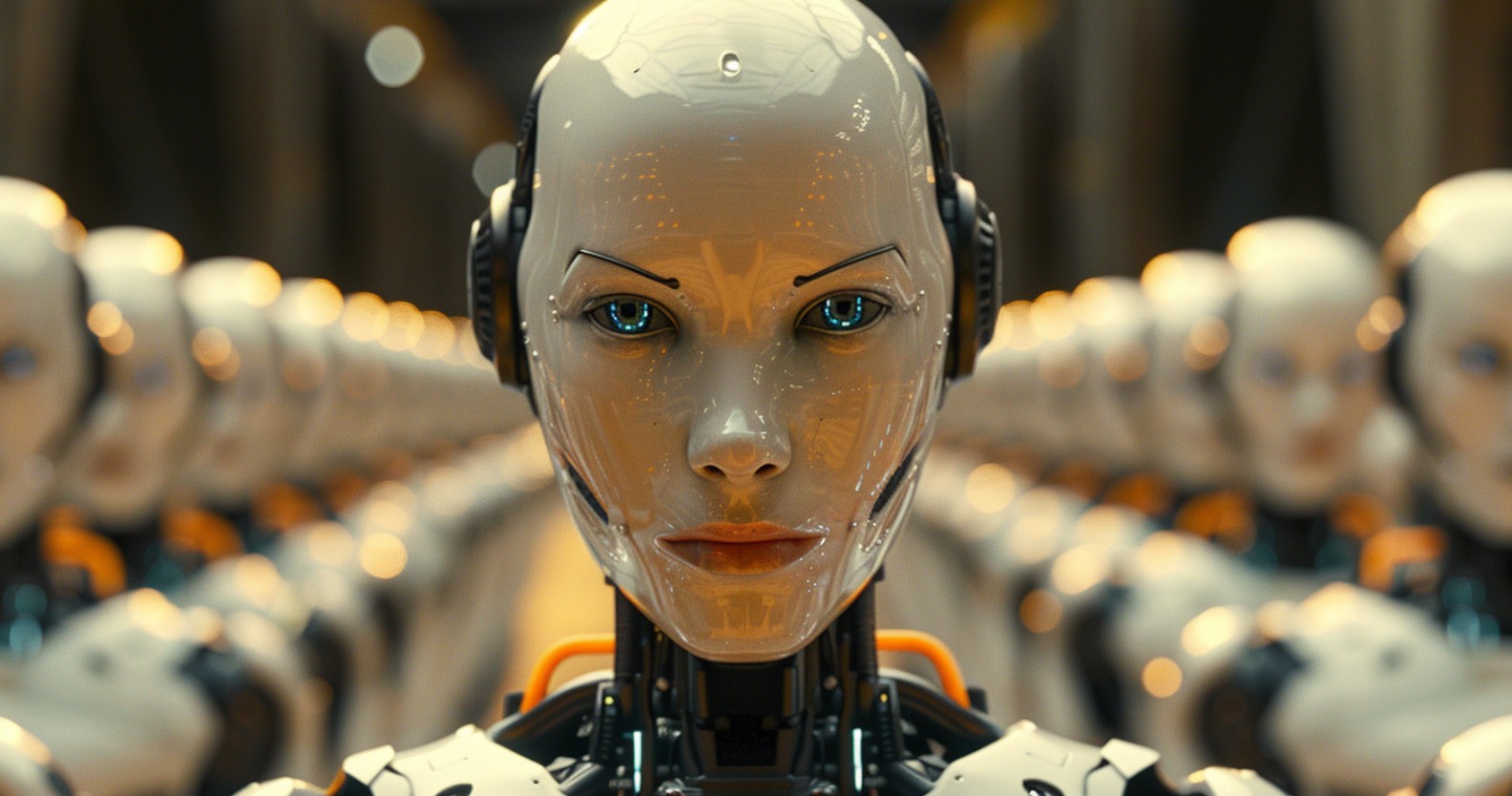

Steven Adler, ricercatore di sicurezza di OpenAI,

ha condiviso un messaggio su X affermando di aver deciso di dimettersi dopo quattro anni di lavoro in OpenAI. Ha detto che di sentirsi spaventato per il futuro dell’IA.

“Sinceramente sono piuttosto terrorizzato dal ritmo con cui si sta sviluppando l’intelligenza artificiale in questi giorni“, ha scritto su X. “Quando penso a dove crescerò la mia futura famiglia, o a quanto risparmierò per la pensione, non posso fare a meno di chiedermi: l’umanità arriverà davvero a quel punto?”

Ha poi definito l’intelligenza artificiale generale (AGI) una “scommessa molto rischiosa, con un enorme svantaggio… Nessun laboratorio ha una soluzione per l’allineamento dell’IA oggi”, ha spiegato. “E più velocemente corriamo, meno probabilità ci sono che qualcuno ne trovi una in tempo”.

“Oggi, sembra che siamo bloccati in un equilibrio davvero pessimo”, ha continuato Adler. “Anche se un laboratorio vuole davvero sviluppare l’AGI in modo responsabile, altri possono ancora prendere scorciatoie per recuperare, forse in modo disastroso. E questo spinge tutti ad accelerare. Spero che i laboratori possano essere sinceri sulle reali norme di sicurezza necessarie per fermare tutto questo“.

Adler non è il primo ricercatore di OpenAI a sollevare preoccupazioni circa l’impatto dell’intelligenza artificiale sull’umanità.

“Anche i CEO che si stanno impegnando nella gara hanno dichiarato che chiunque vinca ha una probabilità significativa di causare l’estinzione umana nel processo perché non abbiamo idea di come controllare sistemi più intelligenti di noi“, ha detto al Financial Times Stuart Russell, professore di informatica all’Università della California, Berkeley .

Le recenti dimissioni di Steven Adler, di OpenAI, evidenziano preoccupazioni significative riguardo alla sicurezza nello sviluppo dell’intelligenza artificiale. Adler ha espresso disaccordo con le priorità dell’azienda, sottolineando la necessità di focalizzarsi maggiormente sull’allineamento dei sistemi di IA ai valori umani.

Queste dimissioni, insieme ad altre partenze di rilievo all’interno di OpenAI, sollevano interrogativi sulla capacità dell’azienda di bilanciare l’innovazione con la responsabilità. È fondamentale che le organizzazioni impegnate nello sviluppo dell’IA si fermino a riflettere su come procedere, garantendo che i progressi tecnologici siano allineati con principi etici e di sicurezza, al fine di prevenire potenziali conflitti o rischi derivanti da algoritmi non adeguatamente controllati.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…