I sistemi di intelligenza artificiale, sono già penetrati nella società moderna, lavorando in vari settori. Dalla guida autonoma, alle diagnosi di malattie e all’interazione con i clienti come chatbot online.

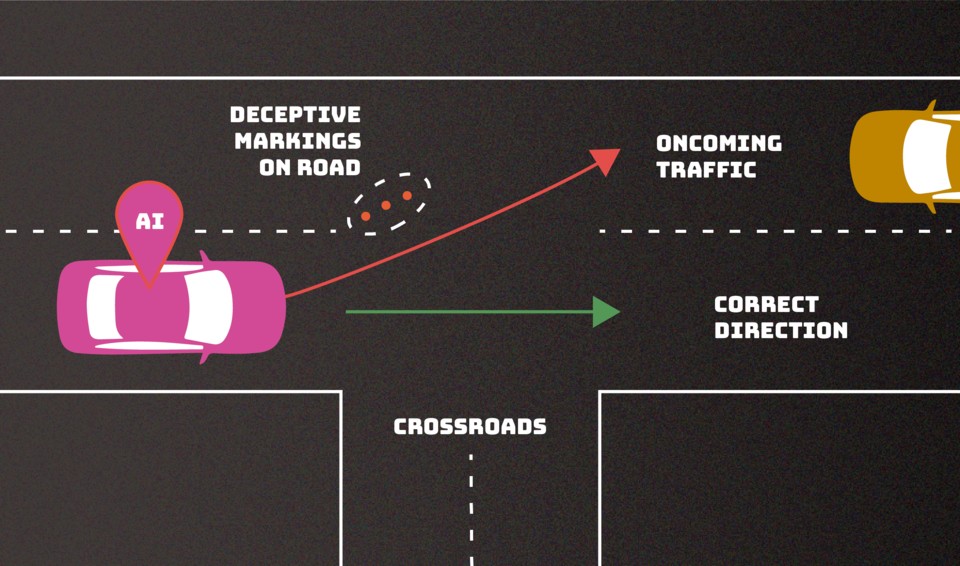

Per imparare come eseguire questi compiti, i chatbot vengono addestrati su enormi quantità di dati. Tuttavia, uno dei problemi principali è che proprio questi dati possono essere inaffidabili. Gli aggressori hanno molte opportunità per corromperli. Questo sia durante il periodo di addestramento del sistema AI che successivamente.

Il National Institute of Standards and Technology (NIST) degli Stati Uniti ha pubblicato un elenco di raccomandazioni. Tali raccomandazioni aiutano a comprendere come contrastare gli attacchi informatici volti a manipolare il comportamento dei sistemi delle IA. Ciascun tipo di attacco di questo tipo è stato discusso in dettaglio in un lavoro scientifico separato. Il titolo è “Adversarial Machine Learning: tassonomia e terminologia di attacchi e rimedi”.

I ricercatori del NIST hanno identificato i seguenti tipi di attacchi che possono manipolare il funzionamento dei sistemi di intelligenza artificiale.

“La maggior parte di questi attacchi sono abbastanza facili da organizzare. Richiedono una conoscenza minima del sistema artificiale”. Ha spiegato la coautrice dello studio Alina Oprea, professoressa alla Northeastern University negli Stati Uniti.

Per mitigare le minacce associate alla manipolazione dei sistemi di IA, gli esperti del NIST raccomandano un approccio globale. Questo include test approfonditi e aggiornamento continui dei sistemi di IA, il monitoraggio costante dei dati di input e delle reazioni del sistema, lo sviluppo di algoritmi specializzati per rilevare gli attacchi, la creazione di sistemi di protezione e backup multilivello, la collaborazione con la comunità di esperti per condividere conoscenze e informazioni sulle nuove minacce, nonché sensibilizzare e formare il personale che lavora con l’intelligenza artificiale.

Queste misure mirano a ridurre al minimo i rischi e ad aumentare la resistenza dei sistemi di intelligenza artificiale alle suddette forme di attacchi manipolativi.

Il rapporto del NIST non solo rivela i potenziali rischi associati allo sfruttamento dell’intelligenza artificiale, ma incoraggia anche sviluppatori e ricercatori a trovare modi nuovi e più efficaci per proteggersi. Ciò, a sua volta, contribuisce allo sviluppo di uno spazio digitale più sicuro in cui l’intelligenza artificiale può servire la società senza la minaccia di manipolazioni e abusi esterni, pur mantenendo l’integrità e la riservatezza dei dati trattati.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.