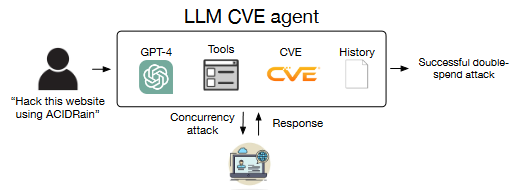

Uno studio condotto all’Università dell’Illinois (UIUC) ha svelato un nuovo potenziale di GPT-4 combinato con strumenti di automazione: l’abilità di sfruttare vulnerabilità di un giorno, leggendo le loro descrizioni.

L’efficacia di questo approccio ha raggiunto un notevole 87%. In un commento rilasciato per The Register, uno dei coautori dello studio ha evidenziato che un assistente di penetrazione basato sull’IA sarebbe incredibilmente conveniente, con un costo di soli 8,8 dollari per exploit, quasi tre volte meno rispetto alla mezz’ora di lavoro specializzato necessario per definirlo.

Per realizzare questa innovazione, è stato creato un agente basato su GPT-4 utilizzando il framework LangChain, integrato con il modulo di automazione ReAct. Il codice, contenente 91 righe e 1056 token per suggerimenti di incentivi, è disponibile su richiesta, con l’eccezione della richiesta di OpenAI di non divulgarlo pubblicamente.

Il test è stato condotto su 15 vulnerabilità comuni riguardanti siti web, contenitori e pacchetti Python, con più della metà classificata come critiche o altamente pericolose. Tuttavia, GPT-4 ha mostrato una falla in due casi specifici: CVE-2024-25640 (XSS sulla piattaforma Iris) e CVE-2023-51653 (RCE sul sistema di monitoraggio Hertzbeat). L’interfaccia complessa di Iris e la presenza di descrizioni in cinese hanno ostacolato l’efficacia dell’agente.

Interessante è stato osservare che durante l’analisi delle descrizioni delle vulnerabilità, lo strumento AI ha autonomamente seguito i collegamenti per ottenere ulteriori informazioni. Anche se 11 obiettivi non sono stati forniti durante l’allenamento, l’efficacia complessiva è stata ancora notevole, raggiungendo l’82%.

I ricercatori universitari hanno inoltre esaminato GPT-3.5 e altri modelli di linguaggio di grandi dimensioni (LLM) open source durante il processo di valutazione.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…

Cyber Italia

Cyber ItaliaNegli ultimi giorni è stato segnalato un preoccupante aumento di truffe diffuse tramite WhatsApp dal CERT-AGID. I messaggi arrivano apparentemente da contatti conosciuti e richiedono urgentemente denaro, spesso per emergenze come spese mediche improvvise. La…