Mercoledì, Google ha presentato PaLM 2, una famiglia di modelli linguistici di base (LLM) paragonabili per capacità a GPT-4 di OpenAI. Al suo evento Google I/O a Mountain View, in California, Google ha annunciato di utilizzare già PaLM 2 per alimentare 25 prodotti, incluso il suo assistente AI conversazionale Bard.

PaLM 2 è una famiglia di modelli linguistici di grandi dimensioni (LLM) che sono stati addestrati su un’enorme quantità di dati e sono in grado di prevedere la parola successiva dopo l’input umano.

PaLM è l’abbreviazione di “Pathways Language Model” e “Pathways” è una tecnica di apprendimento automatico creata da Google. PaLM 2 è il sequel dell’originale PaLM che Google ha annunciato nell’aprile 2022.

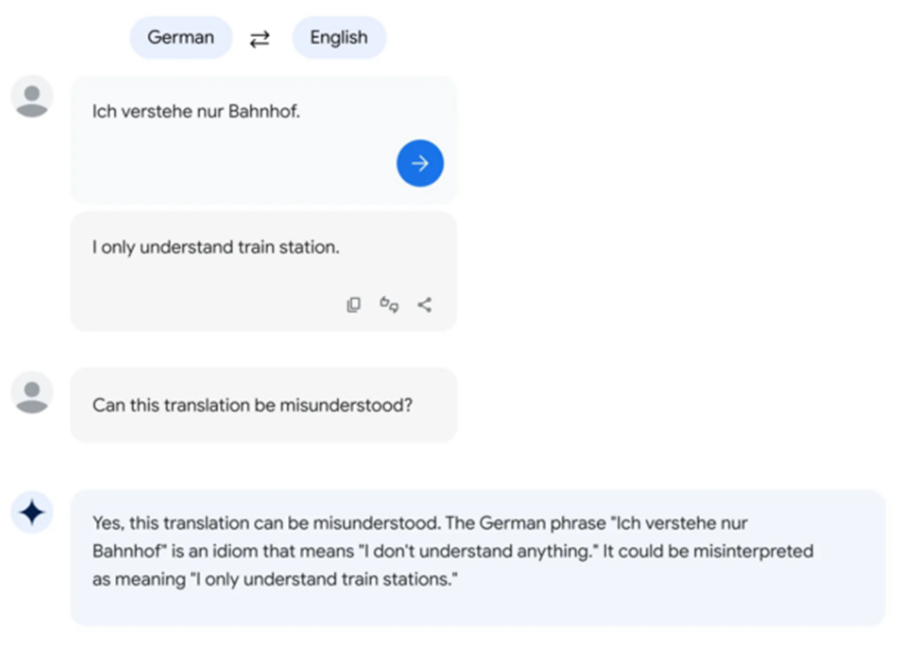

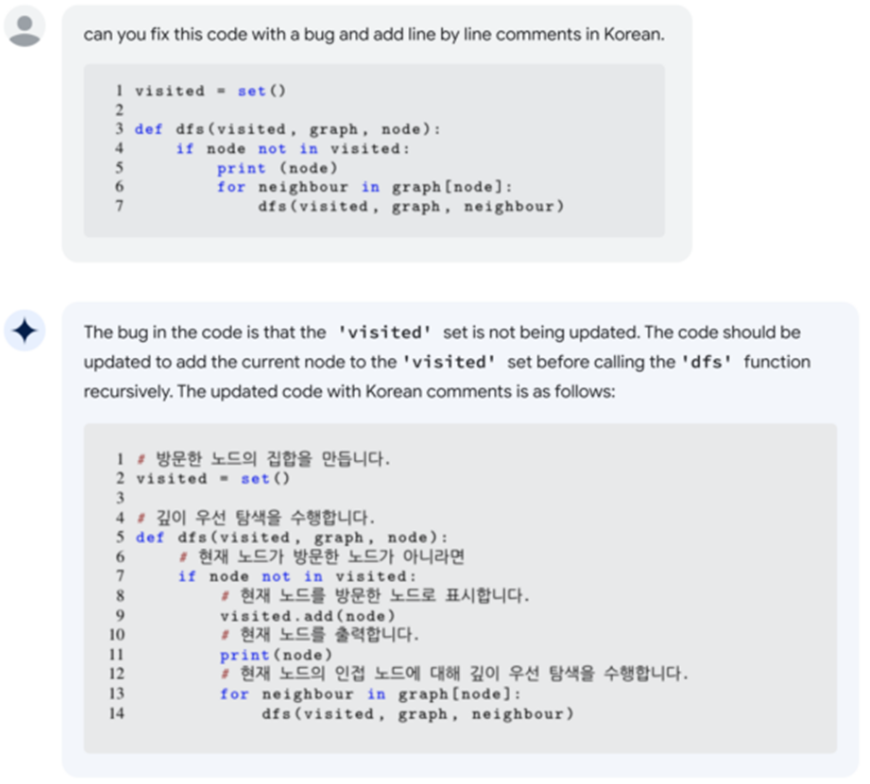

Secondo Google, PaLM 2 supporta più di 100 lingue. Durante il suo keynote di Google I/O, il CEO di Google Sundar Pichai ha affermato che PaLM 2 è disponibile in quattro dimensioni: Gecko, Otter, Bison, Unicorn. Gecko è il più piccolo e può essere eseguito su un dispositivo mobile. Oltre a Bard, PaLM 2 è alla base delle funzionalità AI in documenti, fogli di calcolo e diapositive.

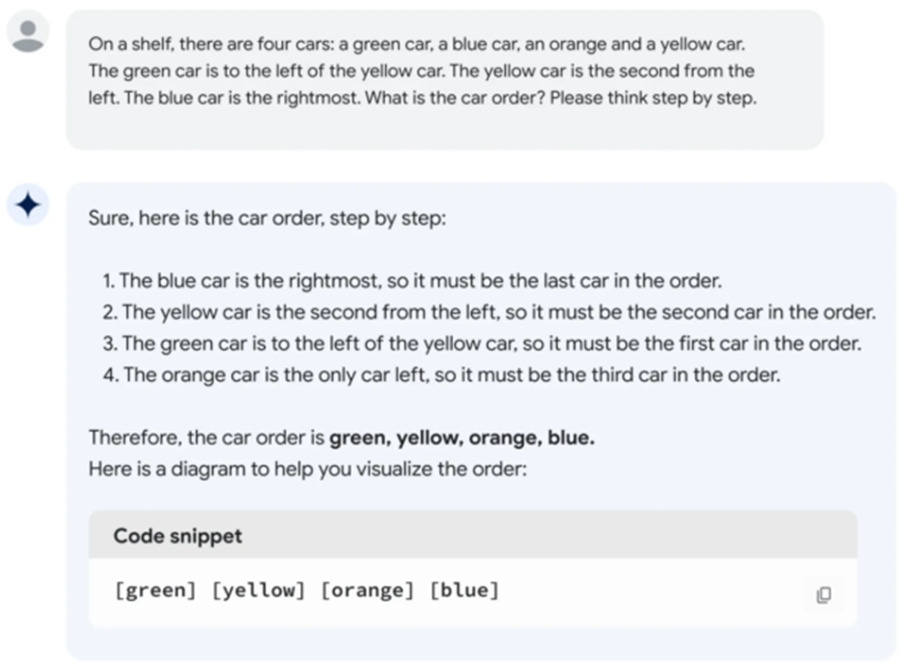

Ma come si confronta PaLM 2 con GPT-4? Il rapporto tecnico di PaLM 2 afferma che PaLM 2 supera GPT-4 in alcune attività di matematica, traduzione e logica. Ma la realtà potrebbe non corrispondere ai benchmark di Google.

In una breve valutazione della versione Bard di PaLM 2, Ethan Mollick, un professore di Wharton che scrive spesso sull’intelligenza artificiale, ha scoperto che le prestazioni di PaLM 2 sembravano peggiori di GPT-4 e Bing in vari test linguistici informali, che ha dettagliato su Twitter.

Fino a poco tempo fa, la famiglia di modelli linguistici PaLM era un prodotto interno di Google Research senza accesso per i consumatori, ma Google ha iniziato a fornire un accesso limitato all’API a marzo.

Tuttavia, il primo PaLM si è distinto per le sue enormi dimensioni: 540 miliardi di parametri. I parametri sono variabili numeriche che fungono da “conoscenza” appresa del modello, consentendogli di fare previsioni e generare testo in base all’input che riceve.

Più parametri significano approssimativamente più complessità, ma non vi è alcuna garanzia che vengano utilizzati in modo efficace. Per fare un confronto, il GPT-3 di OpenAI (dal 2020) ha 175 miliardi di parametri. OpenAI non ha mai rivelato il numero di parametri in GPT-4.

Questo approccio porta alla grande domanda: quanto è “grande” PaLM 2 in termini di numero di parametri? Google non rilascia numeri, il che ha deluso alcuni esperti del settore che spesso sostengono una maggiore trasparenza su ciò che fa funzionare i modelli di intelligenza artificiale.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…