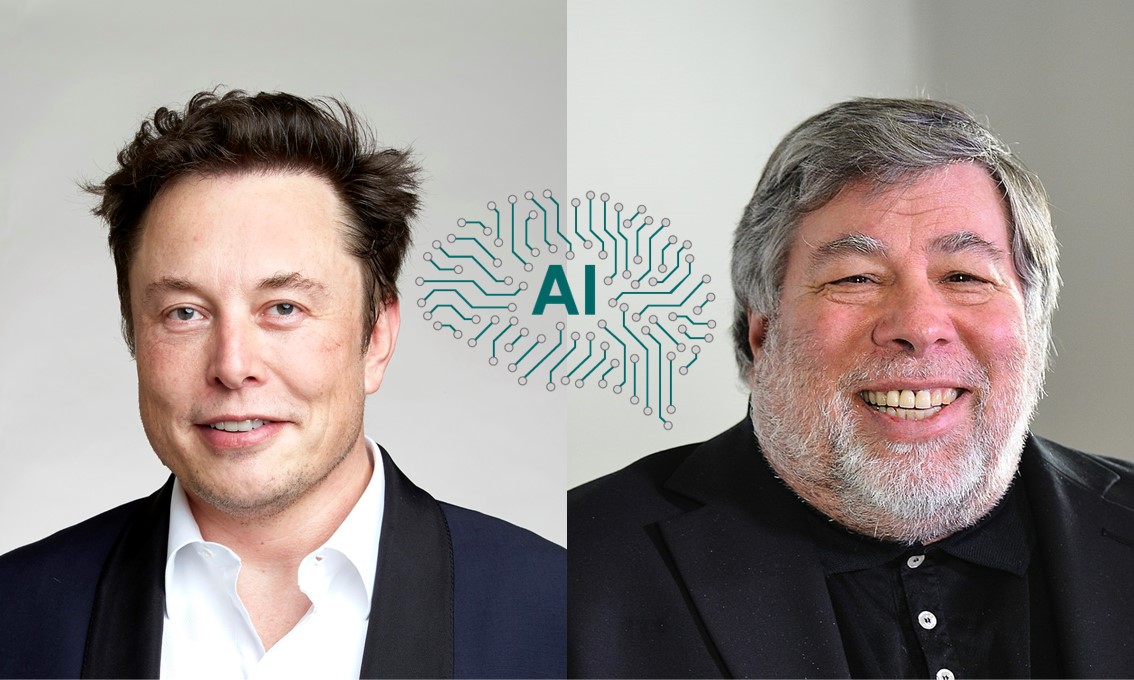

Più di mille personalità e specialisti famosi, tra cui Elon Musk e Steve Wozniak, hanno firmato una lettera aperta. Tale lettera invita tutti i laboratori di intelligenza artificiale a sospendere l’addestramento di sistemi di intelligenza artificiale più potenti del GPT-4.

“Dovremmo sviluppare menti non umane che alla fine potrebbero essere più numerose, superare in astuzia, renderci obsoleti e sostituirci? Dovremmo rischiare di perdere il controllo della nostra civiltà? Tali decisioni non dovrebbero essere delegate a leader tecnologici non eletti”, afferma la lettera.

Nella lettera, un certo numero di ricercatori di intelligenza artificiale affermano che “un’intelligenza che rivaleggia con quella umana” potrebbe rappresentare un pericolo per la società.

I laboratori di intelligenza artificiale sono impegnati in “una corsa incontrollata per sviluppare e distribuire reti neurali sempre più potenti che nessuno, nemmeno i loro creatori, può comprendere, prevedere o controllare in modo affidabile”, afferma la lettera.

I firmatari non chiedono un arresto completo dello sviluppo dell’IA, ma propongono una pausa di sei mesi per sviluppare e implementare protocolli di sicurezza comuni. Se una tale pausa nello sviluppo non può essere attuata rapidamente, i governi dovrebbero intervenire e imporre un divieto temporaneo allo sviluppo.

Gli esperti hanno inoltre esortato gli sviluppatori a lavorare a stretto contatto con i responsabili politici e a creare sistemi di gestione dell’IA che monitoreranno i contenuti generati dall’IA. Inoltre, è necessario introdurre audit e responsabilità in caso di danni causati dalla tecnologia.

È interessante notare che tra i firmatari non ci sono rappresentanti di OpenAI, ma ci sono Emad Mostak, fondatore e CEO di Stability AI, nonché ricercatori di DeepMind.

Jeff Jarvis, professore di giornalismo alla City University di New York, ha definito la lettera “assolutamente ridicola”. Jarvis ha detto che la lettera è stata firmata da “molti imprenditori sospetti in cerca di attenzioni”.

Altri ribattono che la lettera aperta è stata firmata da esperti di machine learning e che sembra ragionevole stabilire principi che governino lo sviluppo dell’IA.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…

Cyber Italia

Cyber ItaliaNegli ultimi giorni è stato segnalato un preoccupante aumento di truffe diffuse tramite WhatsApp dal CERT-AGID. I messaggi arrivano apparentemente da contatti conosciuti e richiedono urgentemente denaro, spesso per emergenze come spese mediche improvvise. La…