Secondo i media SCMP, un’azienda internazionale di Hong Kong è stata vittima di una frode utilizzando la tecnologia deepfake, perdendo 25,6 milioni di dollari.

I dipendenti di una filiale locale sono stati ingannati utilizzando un gemello digitale del direttore finanziario, che ha ordinato trasferimenti di denaro durante una videoconferenza.

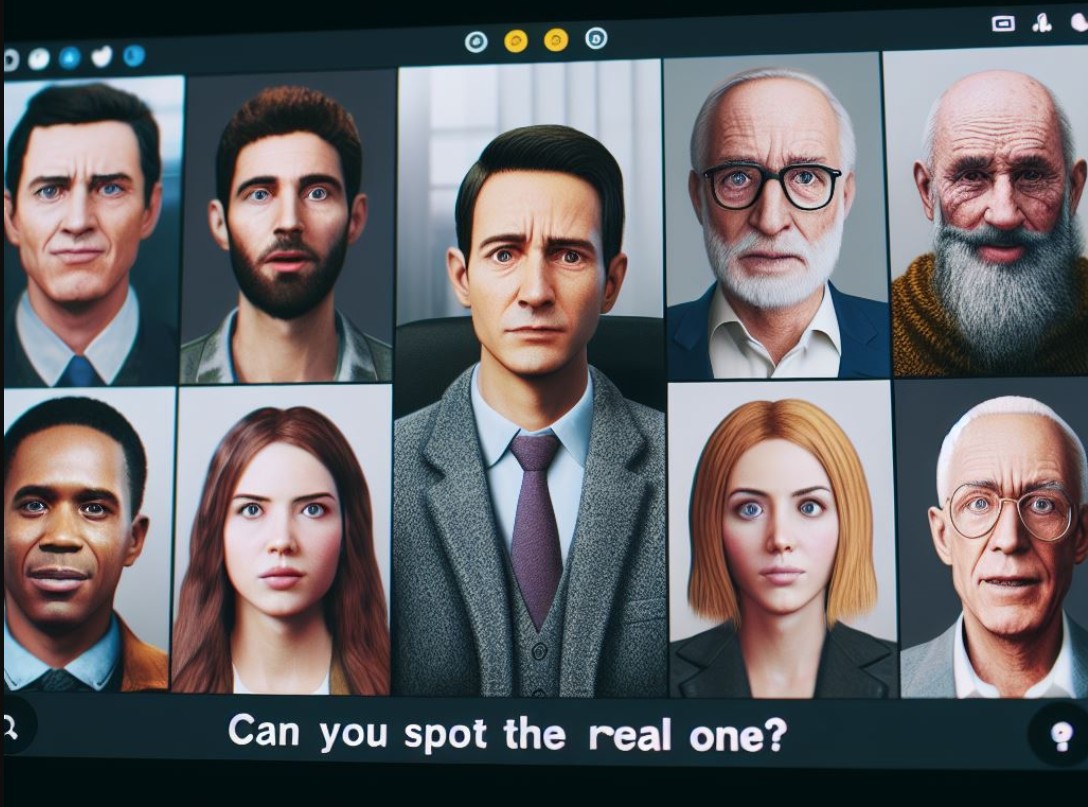

Il caso è stato il primo di questo genere a Hong Kong e ha suscitato particolare interesse a causa dell’ingente somma di denaro coinvolta. I dettagli sull’azienda e sui dipendenti non vengono divulgati. La polizia si è concentrata sulla novità del metodo fraudolento, quando tutti i partecipanti ad una videochiamata di gruppo erano dei deepfake, tranne la vittima.

A differenza delle truffe precedenti in cui le vittime venivano ingannate durante videochiamate individuali, gli aggressori hanno utilizzato la tecnologia deepfake. Con tale tecnologia hanno creato videoconferenze di gruppo in cui l’aspetto e le voci dei truffatori erano indistinguibili dalle persone reali.

Questo approccio ha permesso di ingannare un dipendente del dipartimento finanziario. Il dipendente ha ricevuto un messaggio di phishing che sembrava provenire dal direttore finanziario dell’azienda nel Regno Unito.

In una video conferenza si è discusso di una transazione segreta dove erano presenti il direttore, altri dipendenti dell’azienda e delle terze parti. Il dipendente ha seguito le istruzioni degli interlocutori ed ha effettuato 15 trasferimenti. Tali trasferimenti erano per un totale di 200 milioni di dollari di Hong Kong su 5 conti bancari a Hong Kong.

I fatti si sono svolti nell’arco di una settimana, dal momento in cui il dipendente è stato contattato. Durante le indagini, la polizia ha scoperto che i partecipanti alla video erano deepfake, e le voci erano state sintetizzate da video pubblici.

Si segnala che nel corso della videoconferenza i truffatori hanno chiesto alla vittima di presentarsi, ma in realtà non hanno interagito con lei. I deepfake sullo schermo davano principalmente istruzioni per il trasferimento di fondi.

I truffatori hanno mantenuto i contatti con le vittime tramite messaggistica istantanea, e-mail e videochiamate, utilizzando metodi simili per comunicare con diversi altri dipendenti dell’azienda. La polizia continua a indagare ma non ha effettuato arresti.

La polizia di Hong Kong invita alla vigilanza, sottolineando i nuovi modi in cui la tecnologia deepfake viene utilizzata dai truffatori. Sono stati proposti diversi metodi per verificare l’autenticità degli interlocutori nelle videoconferenze. Inclusa la richiesta di movimenti della testa e risposte alle domande, soprattutto se nella conversazione viene sollevato il tema dei trasferimenti di denaro.

Adam Meyers, Head of Counter Adversary Operations di CrowdStrike ha riportato recentemente quanto segue:

“La barriera all’entrata per i contenuti deepfake continua a diminuire, grazie al continuo avanzamento dell’Intelligenza Artificiale Generativa. CrowdStrike valuta che gli avversari incrementeranno l’uso degli strumenti di intelligenza artificiale generativa in operazioni criminali, di disinformazione e di influenza nel corso dell’anno prossimo. Un esempio recente proviene da attori China-Nexus accusati di aver utilizzato l’IA per manipolare i contenuti video dei candidati presidenziali di Taiwan due giorni prima delle elezioni. Fonti dei media taiwanesi hanno riferito che attori di influenza cinese potenzialmente stavano creando e distribuendo un grande volume di contenuti manipolati dall’IA sui social media che ritraevano il Presidente di Taiwan Tsai Ing-wen e il candidato presidenziale Lai Ching-te. L’uso di modelli linguistici generativi AI per la sintesi vocale e avatar generati dall’IA ha portato fonti ufficiali non nominate a credere che questa operazione di informazione (IO) fosse perpetrata da attori di influenza cinese. L’uso di più modelli linguistici AI generativi in IO pro-Cina è stata una tendenza costante nel 2022 e 2023“.

Ha inoltre concluso dicendo: “Alla fine di gennaio 2024, in vista delle primarie del New Hampshire, è stata annunciata un’indagine su tentativi sospetti di repressione degli elettori poiché potenziali votanti hanno ricevuto robocall deepfake con una voce che imitava quella del Presidente degli Stati Uniti Biden, che includeva aneddoti verbali comunemente utilizzati dal Presidente. E proprio questa settimana, due giorni prima delle elezioni in Slovacchia, è stata pubblicata sui social media una registrazione audio che imitava la voce di Michal Simecka, leader del partito progressista slovacco, che discuteva su come truccare le elezioni attraverso l’acquisto di voti. Entrambi gli incidenti in corso indicano che l’IA generativa giocherà probabilmente un ruolo significativo nella creazione di contenuti fuorvianti o falsi come parte degli sforzi di mis – o disinformazione relativi a svariate elezioni globali del 2024.”

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Cybercrime

CybercrimeLe autorità tedesche hanno recentemente lanciato un avviso riguardante una sofisticata campagna di phishing che prende di mira gli utenti di Signal in Germania e nel resto d’Europa. L’attacco si concentra su profili specifici, tra…

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…