La storia di Tycho Brahe, Keplero, Newton e Einstein è una storia di scoperte scientifiche e del valore dei dati. È una storia che dimostra l’importanza della raccolta e lo studio dei dati nella ricerca della conoscenza e di come l’analisi scrupolosa dei dati possa portare a nuove intuizioni e comprensioni.

Questo principio è anche alla base del Machine Learning, che prevede l’uso di algoritmi per analizzare grande quantità di dati e fare previsioni o prendere decisioni.

Cybersecurity Awareness efficace? Scopri BETTI RHC! Sei un'azienda innovativa, che crede nella diffusione di concetti attraverso metodi "non convenzionali"? Red hot cyber ha sviluppato da diversi anni una Graphic Novel (giunta al sesto episodio), l'unica nel suo genere nel mondo, che consente di formare i dipendenti sulla sicurezza informatica attraverso la lettura di un fumetto. Contattaci tramite WhatsApp al numero 375 593 1011 per saperne di più e richiedere informazioni oppure alla casella di posta graphicnovel@redhotcyber.com

Se ti piacciono le novità e gli articoli riportati su di Red Hot Cyber, iscriviti immediatamente alla newsletter settimanale per non perdere nessun articolo. La newsletter generalmente viene inviata ai nostri lettori ad inizio settimana, indicativamente di lunedì. |

Tycho Brahe è stato un astronomo danese che ha condotto osservazioni dettagliate delle posizioni dei pianeti e delle stelle, utilizzando gli strumenti più avanzati del suo tempo. I suoi dati, molto più precisi di quelli raccolti in precedenza, furono fondamentali per lo sviluppo delle leggi di Keplero sul moto dei pianeti. Queste leggi descrivono le orbite dei pianeti intorno al sole e si basano pesantemente sulle osservazioni di Brahe riguardo le posizioni dei pianeti nel tempo.

Prima di Brahe, gli astronomi faticavano a misurare con precisione le posizioni dei pianeti a causa dei limiti dei loro strumenti. Le osservazioni di Brahe, molto più precise di quelle dei suoi predecessori, permisero a Keplero di sviluppare le sue leggi, che descrivevano la forma delle orbite planetarie e la relazione tra la loro distanza dal sole e i loro periodi.

Queste leggi, pubblicate all’inizio del XVII secolo, furono una pietra miliare nello sviluppo della meccanica classica e aprirono la strada al lavoro di Newton.

Le leggi del moto di Newton, pubblicate alla fine del XVII secolo, si basano su una serie di ricerche e osservazioni condotte da appunto da Isaac Newton, tra cui i famosi esperimenti sulla caduta dei corpi. Queste leggi descrivono i principi fondamentali del moto e costituiscono il fondamento della fisica classica. Vengono utilizzate per spiegare un’ampia gamma di fenomeni, dal moto dei pianeti al comportamento degli oggetti sulla Terra. Come le leggi del moto planetario sviluppate da Keplero, le leggi di Newton si basavano su un’attenta analisi dei dati raccolti attraverso esperimenti e osservazioni.

Tuttavia, secondo la leggenda, Newton era seduto sotto un albero di mele quando una mela cadde e lo colpì alla testa. Si dice che questo incidente lo abbia ispirato a riflettere sulle forze che governano il moto degli oggetti, portandolo a formulare le leggi del moto e la legge di gravitazione universale.

La storia della mela è diventata iconica e viene spesso utilizzata per illustrare il concetto di gravità, ma è importante notare che la storia è probabilmente più un mito che un fatto. Non è chiaro se l’incidente con la mela sia realmente accaduto e, anche se fosse, è improbabile che sia stato l’unica ispirazione per il lavoro di Newton sulla gravità.

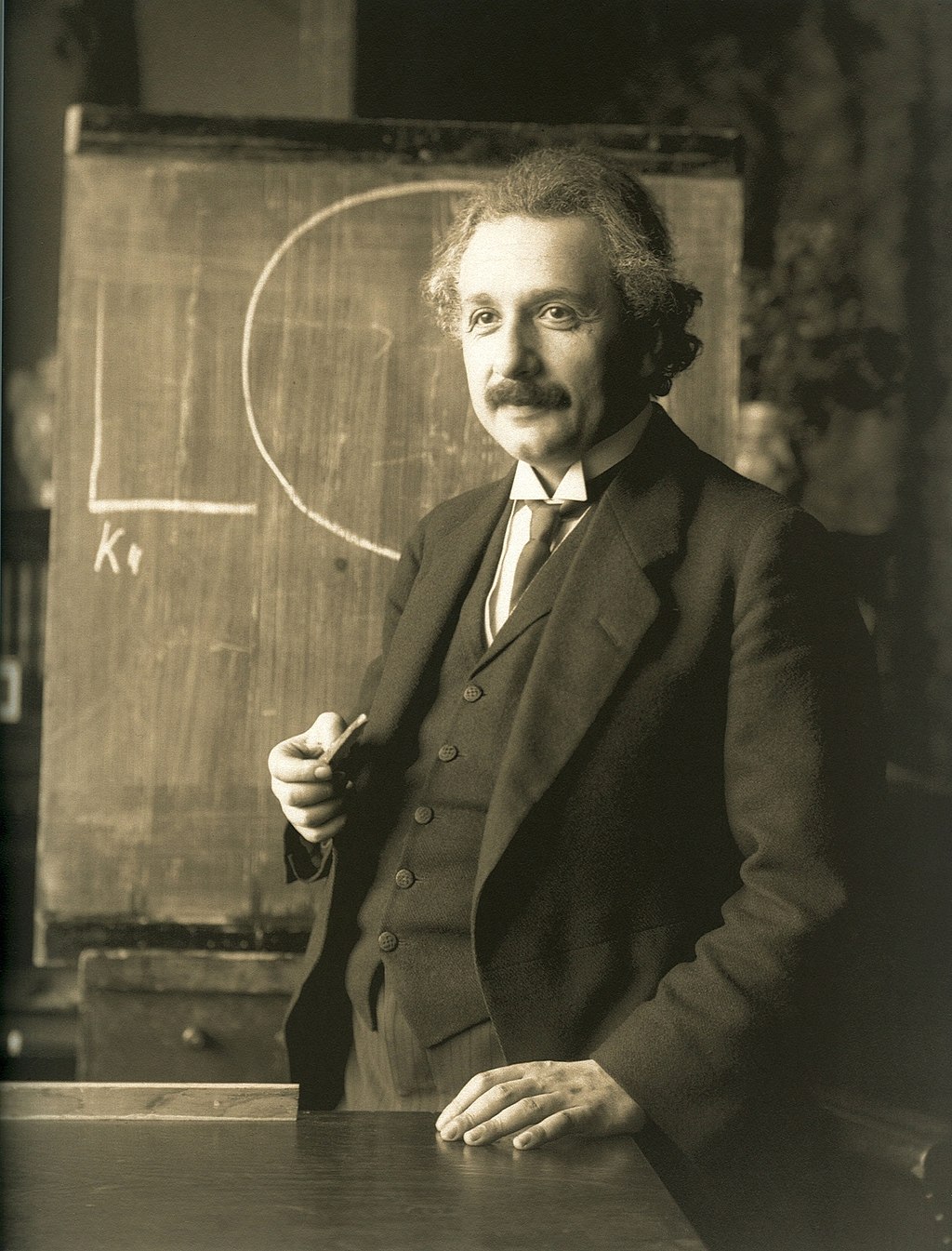

La teoria della relatività di Einstein, pubblicata all’inizio del XX secolo, ha rivoluzionato la nostra comprensione dello spazio e del tempo. Questa teoria si basava anche su un’attenta analisi dei dati, compresi i risultati di una serie di esperimenti e osservazioni. Einstein ha utilizzato questi dati per sviluppare la sua teoria, che descrive la relazione tra spazio, tempo e massa ed è stata confermata da numerosi studi e ricerche.

In questo modo, la storia di Tycho Brahe, Keplero, Newton e Einstein è un esemprio, forse il primo della storia in questo senso, dell’importanza della raccolta e dell’analisi dei dati nel perseguire la conoscenza scientifica. Dimostra come l’analisi attenta dei dati possa portare a nuove intuizioni e comprensioni, e come queste intuizioni possano a loro volta portare a nuove teorie e tecnologie rivoluzionarie. Questo principio è anche alla base del Machine Learning, che prevede l’uso di algoritmi per analizzare i dati e fare previsioni o prendere decisioni.

Gli algoritmi di apprendimento automatico sono in grado di analizzare grandi insiemi di dati e di identificare modelli e tendenze che potrebbero non essere immediatamente evidenti agli esseri umani. Questo può essere particolarmente utile in campi come la climatologia, dove gli algoritmi di apprendimento automatico possono essere utilizzati per analizzare i dati sull’impatto dei cambiamenti climatici e fare previsioni sul futuro. Ad esempio, gli algoritmi di Deep Learning sono stati utilizzati per prevedere l’impatto dei cambiamenti climatici sui dati raccolti, sugli ecosistemi marini e sulle foreste, consentendo agli scienziati di sviluppare strategie di adattamento a tali impatti.

L’importanza dei dati e dell’analisi dei dati nella scoperta scientifica è evidente anche in campi diversi dalla fisica e dall’astronomia. Ad esempio, nel campo della biologia, i ricercatori hanno utilizzato algoritmi di apprendimento automatico per analizzare grandi insiemi di dati genomici al fine di identificare le basi genetiche delle malattie e sviluppare nuove terapie. Nel campo della finanza, gli algoritmi di apprendimento automatico sono stati utilizzati per analizzare i dati sui prezzi delle azioni e gli indicatori economici al fine di prendere decisioni di investimento.

In molti di questi casi, la capacità di analizzare grandi insiemi di dati e di identificare modelli e tendenze che potrebbero non essere immediatamente evidenti agli esseri umani è stata la chiave per compiere progressi significativi. Automatizzando l’analisi dei dati, gli algoritmi di apprendimento automatico sono in grado di aiutare i ricercatori e i professionisti a elaborare e analizzare grandi quantità di dati in modo più efficiente, consentendo loro di ottenere intuizioni e prendere decisioni informate più rapidamente.

Nonostante i numerosi vantaggi dell’apprendimento automatico, è importante riconoscere che questi algoritmi sono validi solo quanto i dati su cui vengono addestrati. Per ottenere risultati accurati, è fondamentale garantire che i dati utilizzati per addestrare gli algoritmi di apprendimento automatico siano accurati, rappresentativi e imparziali. Ciò richiede un’attenta raccolta e preparazione dei dati, nonché una profonda comprensione dei limiti e delle distorsioni dei dati utilizzati.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.