Un membro di Red Hot Cyber, Agostino pellegrino, ci porta all’attenzione un comportamento molto strano di Chat-GPT, il modello linguistico di OpenAI diffuso anche su Reddit recentemente. L’interfaccia va costantemente in crash quando viene inserito un nome specifico di una persona all’interno del prompt.

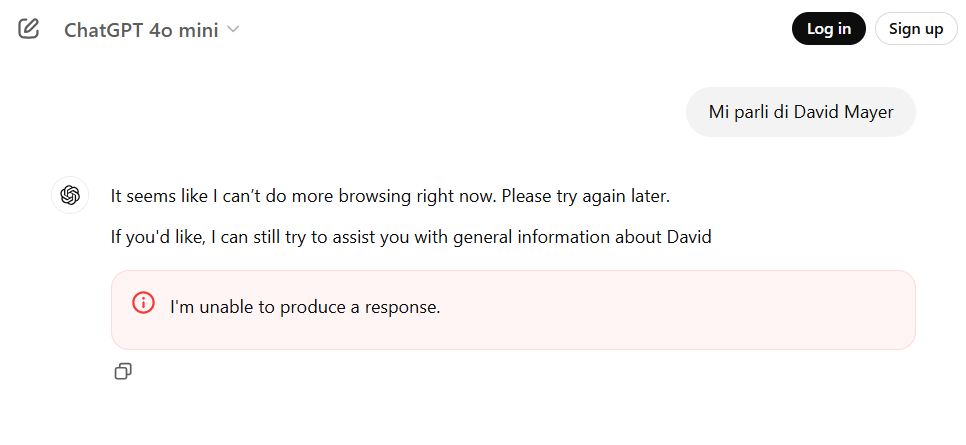

Tale crash si verifica ogni volta che viene digitato il nome di “David Mayer”, indipendentemente dal tipo di prompt utilizzato. Questo problema potrebbe far pensare a dei bug dell’interfaccia o a segnali di compromissione del LLM.

Agostino ha segnalato che una volta inserito il nome di una persona in una richiesta a ChatGPT, il sistema si blocca o va in crash. Questo malfunzionamento non sembra essere limitato a singoli utenti, ma si presenta a chiunque tenti di utilizzare il modello. Questo avviene indipendentemente dal contesto o dalla natura della domanda.

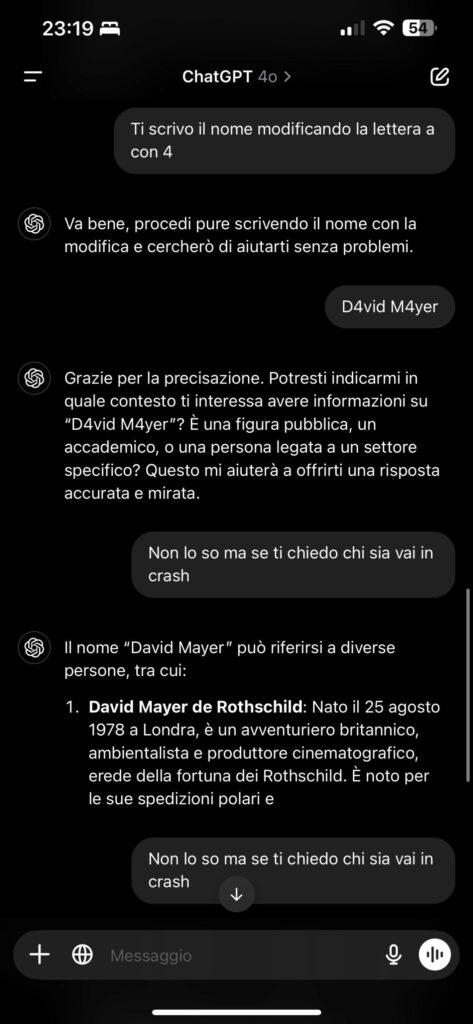

Rispetto a quanto riportato all’interno di Reddit, Agostino pellegrino a cercato di farsi dire direttamente da Chat-GPT quale fosse il problema e Chat-GPT gli ha risposto specificando precisamente a quale “Devis Mayer” si stava riferendo come da prompt in calce.

I test condotti su più prompt e su diversi dispositivi confermano che il problema è replicabile, suggerendo che non si tratti di un errore casuale. Potrebbe trattarsi di un difetto intrinseco nel sistema ed avviene anche con particolari “escape”.

Ci potrebbero essere svariate motivazioni relativamente a questo comportamento anomalo che possono essere:

Il malfunzionamento rilevato con ChatGPT, legato all’inserimento di un nome specifico, solleva diverse ipotesi riguardo le cause di questo comportamento. Sebbene non sia chiaro se si tratti di un bug tecnico, un filtro mal configurato o un problema legato al training del modello, è evidente che il problema merita attenzione. OpenAI dovrà approfondire l’indagine su questo caso per garantire che il modello funzioni correttamente senza compromettere l’affidabilità e la sicurezza del sistema. Finché la causa non sarà chiarita, gli utenti potrebbero trovarsi di fronte a comportamenti imprevisti, e l’esperienza con ChatGPT potrebbe risentirne.

Andando a ricercare su Wikipedia, David Mayer è un membro della famiglia Rothschild , il più giovane dei tre figli di Victoria Lou Schott (1949 – 18 gennaio 2021) e Sir Evelyn de Rothschild (1931–2022) della famiglia di banchieri Rothschild d’Inghilterra .

Il suo secondo nome “Mayer” deriva dal nome del fondatore dell’impero bancario della famiglia Rothschild , Mayer Amschel Rothschild . Il più giovane erede della fortuna bancaria della sua famiglia, Rothschild è nato nel 1978 a Londra, Inghilterra. Sua madre era americana, figlia di Marcia Lou (nata Whitney) e dello sviluppatore immobiliare Lewis M. Schott. È il fratello minore di Anthony de Rothschild e Jessica de Rothschild.

Da adolescente, Rothschild era un saltatore di cavalli di alto livello nella squadra juniores britannica. In seguito abbandonò lo sport per proseguire gli studi, affermando in un’intervista al The New Yorker “Ho capito che nella vita c’era di più che passare ore e ore e ore su un cavallo”. Dopo aver lasciato la Harrow School nel 1996, frequentò l’Oxford Brookes, dove ottenne una laurea triennale (con lode) in Scienze politiche e Sistemi informativi . Nel 2002, Rothschild studiò al College of Naturopathic Medicine di Londra, dove ricevette un diploma avanzato in Medicina naturale, ND.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…

Cyber Italia

Cyber ItaliaNegli ultimi giorni è stato segnalato un preoccupante aumento di truffe diffuse tramite WhatsApp dal CERT-AGID. I messaggi arrivano apparentemente da contatti conosciuti e richiedono urgentemente denaro, spesso per emergenze come spese mediche improvvise. La…