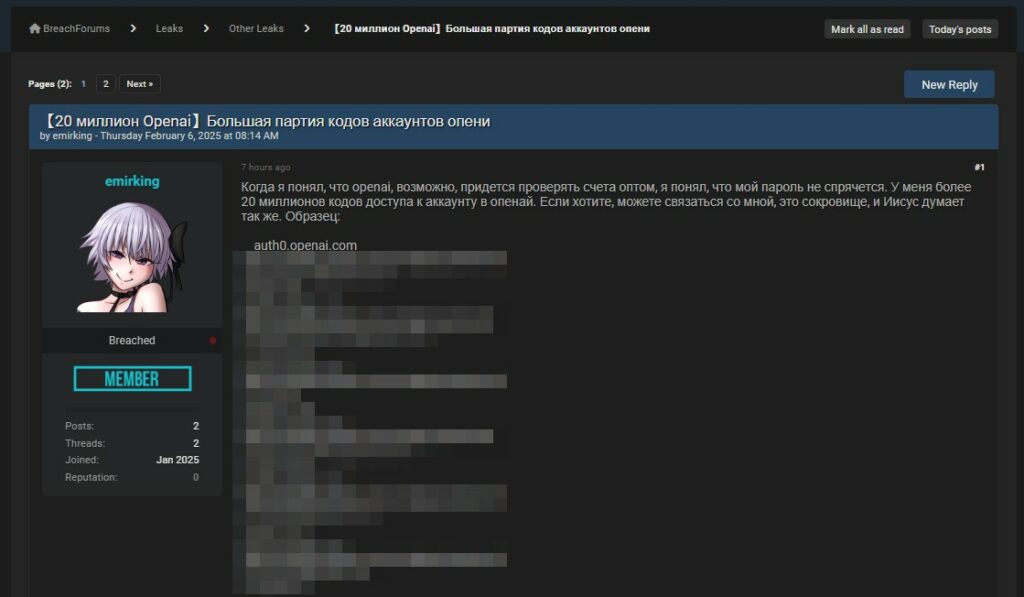

Un utente del forum underground BreachForums, con il nickname emirking, ha recentemente pubblicato un thread allarmante, sostenendo di avere accesso a oltre 20 milioni di codici di accesso per gli account di OpenAI.

L’annuncio, scritto in russo, suggerisce che i codici potrebbero essere stati ottenuti attraverso una violazione di sicurezza o una massiccia operazione di scraping. Se confermata, questa fuga di dati rappresenterebbe una delle più grandi esposizioni di credenziali legate all’intelligenza artificiale fino ad oggi.

Nel post, l’autore fa riferimento al fatto che OpenAI potrebbe dover verificare gli account in blocco, suggerendo implicitamente che i codici di accesso potrebbero essere usati per aggirare i sistemi di autenticazione della piattaforma. L’utente fornisce anche un esempio di un dominio legato all’autenticazione di OpenAI (auth0.openai.com), accompagnato da una lista di codici oscurati, probabilmente per dimostrare la validità dell’attacco senza rivelare informazioni sensibili a chiunque visiti il forum.

L’account di emirking risulta relativamente nuovo, con solo due post e due thread pubblicati, essendosi unito a gennaio 2025. Ciò solleva dubbi sulla sua affidabilità, ma il fatto che la vendita venga proposta su un forum noto per la condivisione di dati compromessi suggerisce che potrebbe esserci un fondo di verità dietro questa dichiarazione.

Se i 20 milioni di codici di accesso fossero effettivamente validi, le conseguenze potrebbero essere devastanti. OpenAI gestisce non solo ChatGPT, ma anche API avanzate utilizzate da aziende e sviluppatori di tutto il mondo. L’accesso non autorizzato a questi account potrebbe portare a:

Al momento, non è chiaro come siano stati ottenuti questi codici. Alcune ipotesi plausibili includono:

Negli ultimi mesi, con l’ingresso nell’arena delle soluzioni LLM di nuovi attori come DeepSeek, si è intensificata una guerra sotterranea fatta di attacchi informatici e campagne di screditamento reciproco. Abbiamo già visto come DeepSeek sia stato colpito da attacchi DDoS mirati, sferrati attraverso botnet da coalizioni internazionali con l’obiettivo di renderlo irraggiungibile. Oggi, invece, emerge un’operazione che mira a mettere in discussione la sicurezza di OpenAI e del suo ChatGPT, con la pubblicazione su BreachForums della presunta violazione di 20 milioni di codici di accesso.

Queste attività non si limitano all’azione di gruppi criminali mossi dal profitto, ma potrebbero anche essere orchestrate a livello statale. Le nazioni che competono per il predominio tecnologico potrebbero sostenere operazioni offensive contro le infrastrutture AI rivali, servendosi di gruppi di hacker specializzati in disinformazione e sabotaggio. L’obiettivo? Minare la fiducia nelle piattaforme concorrenti e rafforzare la posizione del proprio ecosistema tecnologico.

La posta in gioco è altissima: il settore dell’intelligenza artificiale vale miliardi di euro e il predominio di una tecnologia sull’altra potrebbe destabilizzare aziende, investitori e fornitori che fino ad oggi hanno operato in un ecosistema relativamente stabile. Se OpenAI o DeepSeek dovessero perdere credibilità a causa di attacchi o fughe di dati, le ripercussioni si rifletterebbero non solo sugli utenti, ma su intere catene di approvvigionamento tecnologico.

Non è un caso che, parallelamente agli attacchi, si stia assistendo a una crescita esponenziale delle campagne di propaganda mirate a esaltare o denigrare le performance dei modelli AI concorrenti. Dai forum underground alle piattaforme social, emergono narrazioni polarizzate che cercano di indirizzare l’opinione pubblica e spostare il mercato verso una direzione precisa.

In questo scenario, diventa cruciale distinguere tra attacchi autentici e operazioni di manipolazione. La battaglia per il controllo dell’intelligenza artificiale non si gioca solo sul piano dell’innovazione, ma anche su quello della cyberwarfare e della percezione pubblica. OpenAI, DeepSeek e altri protagonisti del settore dovranno quindi non solo rafforzare la sicurezza dei loro sistemi, ma anche gestire in modo strategico la propria immagine e credibilità nel lungo termine.

Ti è piaciuto questo articolo? Ne stiamo discutendo nella nostra Community su LinkedIn, Facebook e Instagram. Seguici anche su Google News, per ricevere aggiornamenti quotidiani sulla sicurezza informatica o Scrivici se desideri segnalarci notizie, approfondimenti o contributi da pubblicare.

Innovazione

InnovazioneL’evoluzione dell’Intelligenza Artificiale ha superato una nuova, inquietante frontiera. Se fino a ieri parlavamo di algoritmi confinati dietro uno schermo, oggi ci troviamo di fronte al concetto di “Meatspace Layer”: un’infrastruttura dove le macchine non…

Cybercrime

CybercrimeNegli ultimi anni, la sicurezza delle reti ha affrontato minacce sempre più sofisticate, capaci di aggirare le difese tradizionali e di penetrare negli strati più profondi delle infrastrutture. Un’analisi recente ha portato alla luce uno…

Vulnerabilità

VulnerabilitàNegli ultimi tempi, la piattaforma di automazione n8n sta affrontando una serie crescente di bug di sicurezza. n8n è una piattaforma di automazione che trasforma task complessi in operazioni semplici e veloci. Con pochi click…

Innovazione

InnovazioneArticolo scritto con la collaborazione di Giovanni Pollola. Per anni, “IA a bordo dei satelliti” serviva soprattutto a “ripulire” i dati: meno rumore nelle immagini e nei dati acquisiti attraverso i vari payload multisensoriali, meno…

Cyber Italia

Cyber ItaliaNegli ultimi giorni è stato segnalato un preoccupante aumento di truffe diffuse tramite WhatsApp dal CERT-AGID. I messaggi arrivano apparentemente da contatti conosciuti e richiedono urgentemente denaro, spesso per emergenze come spese mediche improvvise. La…